持续集成及JenKins介绍

配套原版资料:Jenkins持续集成从入门到精通.pdf

软件开发生命周期【需求分析、设计、实现、测试、进化】

软件开发瀑布模型

瀑布模型是最著名和最常使用的软件开发模型。瀑布模型就是一系列的软件开发过程。它是由制造业繁 衍出来的。一个高度化的结构流程在一个方向上流动,有点像生产线一样。在瀑布模型创建之初,没有 其它开发的模型,有很多东西全靠开发人员去猜测,去开发。这样的模型仅适用于那些简单的软件开 发, 但是已经不适合现在的开发了。

| 优势 |

劣势 |

| 简单易用和理解 |

各个阶段的划分完全固定,阶段之间产生大量的文档,极大地 增加了工作量。 |

| 当前一阶段完成后,您只需要 去关注后续阶段 |

由于开发模型是线性的,用户只有等到整个过程的末期才能见 到开发成果,从而增加了开发风险 |

| 为项目提供了按阶段划分的检 查节点 |

瀑布模型的突出缺点是不适应用户需求的变化 |

软件开发敏捷开发模型

敏捷开发(Agile Development) 的核心是迭代开发(Iterative Development) 与 增量开发 (Incremental Development) 。

==何为迭代开发?== 对于大型软件项目,传统的开发方式是采用一个大周期(比如一年)进行开发,整个过程就是一次”大 开发”;迭代开发的方式则不一样,它将开发过程拆分成多个小周期,即一次”大开发”变成多次”小开 发”,每次小开发都是同样的流程,所以看上去就好像重复在做同样的步骤。 举例来说,SpaceX 公司想造一个大推力火箭,将人类送到火星。但是,它不是一开始就造大火箭,而 是先造一个最简陋的小火箭 Falcon 1。结果,第一次发射就爆炸了,直到第四次发射,才成功进入轨 道。然后,开发了中型火箭 Falcon 9,九年中发射了70次。最后,才开发 Falcon 重型火箭。如果 SpaceX 不采用迭代开发,它可能直到现在还无法上天。

==何为增量开发?== 软件的每个版本,都会新增一个用户可以感知的完整功能。也就是说,按照新增功能来划分迭代。 举例来说,房产公司开发一个10栋楼的小区。如果采用增量开发的模式,该公司第一个迭代就是交付一 号楼,第二个迭代交付二号楼……每个迭代都是完成一栋完整的楼。而不是第一个迭代挖好10栋楼的地 基,第二个迭代建好每栋楼的骨架,第三个迭代架设屋顶…..

敏捷开发如何迭代?

虽然敏捷开发将软件开发分成多个迭代,但是也要求,每次迭代都是一个完整的软件开发周期,必须按 照软件工程的方法论,进行正规的流程管理。

敏捷开发有什么好处?

==早期交付== 敏捷开发的第一个好处,就是早期交付,从而大大降低成本。 还是以上一节的房产公司为例,如果按照 传统的”瀑布开发模式”,先挖10栋楼的地基、再盖骨架、然后架设屋顶,每个阶段都等到前一个阶段完 成后开始,可能需要两年才能一次性交付10栋楼。也就是说,如果不考虑预售,该项目必须等到两年后 才能回款。 敏捷开发是六个月后交付一号楼,后面每两个月交付一栋楼。因此,半年就能回款10%,后 面每个月都会有现金流,资金压力就大大减轻了。

==降低风险== 敏捷开发的第二个好处是,及时了解市场需求,降低产品不适用的风险。 请想一想,哪一种情况损失比 较小:10栋楼都造好以后,才发现卖不出去,还是造好第一栋楼,就发现卖不出去,从而改进或停建后面9栋楼

持续集成

持续集成( Continuous integration , 简称 CI )指的是,频繁地(一天多次)将代码集成到主干。 持续集成的目的,就是让产品可以快速迭代,同时还能保持高质量。它的核心措施是,代码集成到主干 之前,必须通过自动化测试。只要有一个测试用例失败,就不能集成。 通过持续集成, 团队可以快速的从一个功能到另一个功能,简而言之,敏捷软件开发很大一部分都要归 功于持续集成

持续集成的流程

提交

流程的第一步,是开发者向代码仓库提交代码。所有后面的步骤都始于本地代码的一次提交 (commit)。

测试(第一轮)

代码仓库对commit操作配置了钩子(hook),只要提交代码或者合并进主干,就会跑自动化测试。

构建

通过第一轮测试,代码就可以合并进主干,就算可以交付了。 交付后,就先进行构建(build),再进入第二轮测试。所谓构建,指的是将源码转换为可以运行的实 际代码,比如安装依赖,配置各种资源(样式表、JS脚本、图片)等等。

测试(第二轮)

构建完成,就要进行第二轮测试。如果第一轮已经涵盖了所有测试内容,第二轮可以省略,当然,这时 构建步骤也要移到第一轮测试前面。

部署

过了第二轮测试,当前代码就是一个可以直接部署的版本(artifact)。将这个版本的所有文件打包( tar filename.tar * )存档,发到生产服务器。

回滚

一旦当前版本发生问题,就要回滚到上一个版本的构建结果。最简单的做法就是修改一下符号链接,指 向上一个版本的目录

持续集成的组成要素

- 一个自动构建过程, 从检出代码、 编译构建、 运行测试、 结果记录、 测试统计等都是自动完成 的,无需人工干预。

- 一个代码存储库,即需要版本控制软件来保障代码的可维护性,同时作为构建过程的素材库,一般使用SVN或Git。

- 一个持续集成服务器,Jenkins 就是一个配置简单和使用方便的持续集成服务器

持续集成的好处

1、降低风险,由于持续集成不断去构建,编译和测试,可以很早期发现问题,所以修复的代价就少;

2、对系统健康持续检查,减少发布风险带来的问题;

3、减少重复性工作;

4、持续部署,提供可部署单元包;

5、持续交付可供使用的版本;

6、增强团队信心

JenKins介绍

Jenkins 是一款流行的开源持续集成(Continuous Integration)工具,广泛用于项目开发,具有自动化构建、测试和部署等功能。官网: http://jenkins-ci.org/

CI:持续集成(Continuous Integration)

CD:持续部署(Continuous ????)

Jenkins的特征:

- 开源的 Java语言开发持续集成工具,支持持续集成,持续部署。

- 易于安装部署配置:可通过 方便web界面配置管理。

- 消息通知及测试报告:集成 yum安装,或下载war包以及通过docker容器等快速实现安装部署,可 RSS/E-mail通过RSS发布构建结果或当构建完成时通过e-mail通知,生成JUnit/TestNG测试报告。 Jenkins能够让多台计算机一起构建/测试。

- 分布式构建:支持

- 文件识别: Jenkins能够跟踪哪次构建生成哪些jar,哪次构建使用哪个版本的jar等。

- 丰富的插件支持:支持扩展插件,你可以开发适合自己团队使用的工具,如 docker等

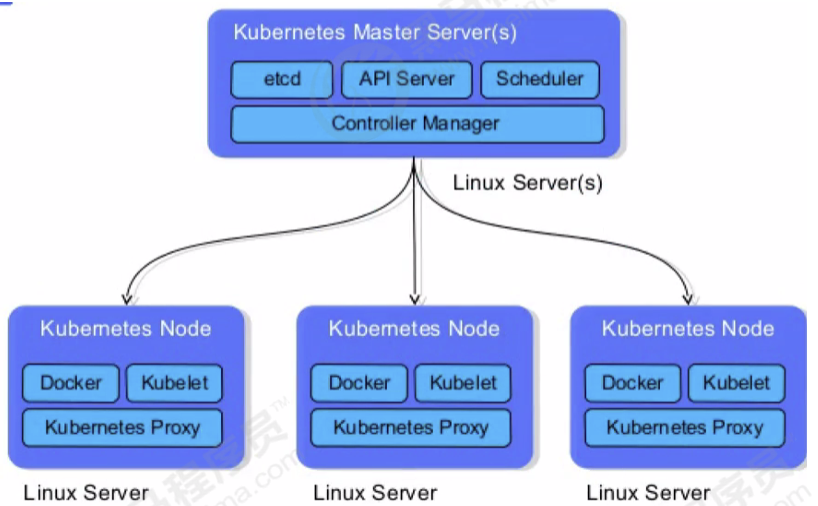

服务器列表[统一使用CentOS7]

| 名称 |

IP地址 |

安装的软件 |

| 代码托管服务器 |

192.168.200.128 |

Gitlab-12.4.2 |

| 持续集成服务器 |

192.168.200.129 |

Jenkins-2.190.3,JDK1.8,Maven3.6.2,Git, SonarQube |

| 应用测试服务器 |

192.168.66.102 |

JDK1.8,Tomcat8.5 |

Gitlab[团队个人版github]代码托管服务器安装

[lanyun_group / web_demo · GitLab] (http://192.168.200.128:82/lanyun_group/web_demo)

官网: https://about.gitlab.com/

GitLab 是一个用于仓库管理系统的开源项目,使用Git作为代码管理工具,并在此基础上搭建起来的 web服务。

GitLab和GitHub一样属于第三方基于Git开发的作品,免费且开源(基于MIT协议),与Github类似, 可以注册用户,任意提交你的代码,添加SSHKey等等。不同的是,GitLab是可以部署到自己的服务器 上,数据库等一切信息都掌握在自己手上,适合团队内部协作开发,你总不可能把团队内部的智慧总放 在别人的服务器上吧?简单来说可把GitLab看作个人版的GitHub

安装相关依赖

yum -y install policycoreutils openssh-server openssh-clients postfix

启动ssh服务&设置为开机启动

systemctl enable sshd && sudo systemctl start sshd

设置postfix开机自启,并启动,postfix支持gitlab发信功能

systemctl enable postfix && systemctl start postfix

开放ssh以及http服务,然后重新加载防火墙列表

firewall-cmd –add-service=ssh –permanent

firewall-cmd –add-service=http –permanent

firewall-cmd –reload

如果关闭防火墙就不需要做以上配置

下载gitlab包,并且安装

在线下载安装包:

wget https://mirrors.tuna.tsinghua.edu.cn/gitlab-ce/yum/el6/gitlab-ce-12.4.2-ce.0.el6.x 86_64.rpm 安装:

rpm -i gitlab-ce-12.4.2-ce.0.el6.x86_64.rpm

修改gitlab配置

vi /etc/gitlab/gitlab.rb

修改gitlab访问地址和端口,默认为80,我们改为82

external_url ‘ http://192.168.200.132:82'

nginx[‘listen_port’] = 82

重载配置及启动gitlab

gitlab-ctl reconfigure

gitlab-ctl restart ★★

把端口添加到防火墙

firewall-cmd –zone=public –add-port=82/tcp –permanent

firewall-cmd –reload

启动成功后,看到以下修改管理员root密码的页面,修改密码后,然后登录即可

账号:root

密码:panchunyao123

Gitlab用户在组里面有5种不同权限:

Guest:可以创建issue、发表评论,不能读写版本库

Reporter:可以克隆代码,不能提交,QA、PM 可以赋予这个权限

Developer:可以克隆代码、开发、提交、push,普通开发可以赋予这个权限

Maintainer:可以创建项目、添加tag、保护分支、添加项目成员、编辑项目,核心开发可以赋予这个 权限 Owner:可以设置项目访问权限 - Visibility Level、删除项目、迁移项目、管理组成员,开发组组 长可以赋予这个权限

如果张三被管理员添加了Owner权限,那么张三就可以在idea里面通过gitlab里面的仓库地址 上传项目到这个web_demo了。

持续集成环境—Jenkins安装【我用了最新的Jenkins 2.440.1】

[Setup Wizard [Jenkins]] (http://192.168.200.129:8888/)

安装目录为:/usr/lib/jvm

下载页面: https://jenkins.io/zh/download/

安装文件:jenkins-2.190.3-1.1.noarch.rpm

修改内容如下:

JENKINS_USER=”root”

JENKINS_PORT=”8888”

综上操作

[root@localhost ~]# java -version

java version “21.0.1” 2023-10-17 LTS

Java(TM) SE Runtime Environment (build 21.0.1+12-LTS-29)

Java HotSpot(TM) 64-Bit Server VM (build 21.0.1+12-LTS-29, mixed mode, sharing)

[root@localhost ~]# cd /usr/lib/jvm

[root@localhost jvm]# ll

总用量 0

lrwxrwxrwx. 1 root root 26 6月 15 16:27 java -> /etc/alternatives/java_sdk

lrwxrwxrwx. 1 root root 32 6月 15 16:27 java-1.8.0 -> /etc/alternatives/java_sdk_1.8.0

lrwxrwxrwx. 1 root root 40 6月 15 16:27 java-1.8.0-openjdk -> /etc/alternatives/java_sdk_1.8.0_openjdk

drwxr-xr-x. 9 root root 109 6月 15 16:27 java-1.8.0-openjdk-1.8.0.262.b10-1.el7.x86_64

lrwxrwxrwx. 1 root root 34 6月 15 16:27 java-openjdk -> /etc/alternatives/java_sdk_openjdk

lrwxrwxrwx. 1 root root 21 6月 15 16:27 jre -> /etc/alternatives/jre

lrwxrwxrwx. 1 root root 27 6月 15 16:27 jre-1.8.0 -> /etc/alternatives/jre_1.8.0

lrwxrwxrwx. 1 root root 35 6月 15 16:27 jre-1.8.0-openjdk -> /etc/alternatives/jre_1.8.0_openjdk

lrwxrwxrwx. 1 root root 49 6月 15 16:27 jre-1.8.0-openjdk-1.8.0.262.b10-1.el7.x86_64 -> java-1.8.0-openjdk-1.8.0.262.b10-1.el7.x86_64/jre

lrwxrwxrwx. 1 root root 29 6月 15 16:27 jre-openjdk -> /etc/alternatives/jre_openjdk

[root@localhost jvm]# cd java-1.8.0-openjdk

[root@localhost java-1.8.0-openjdk]#

下一步:你只需要执行 升级Jenkins的升级流程

以下是你的专属升级操作指令合集(CentOS 7 专用):

🔧 1. 备份 Jenkins 数据(可选但强烈推荐)

sudo systemctl stop jenkins

sudo cp -r /var/lib/jenkins /var/lib/jenkins_backup_$(date +%F)

sudo cp /etc/sysconfig/jenkins /etc/sysconfig/jenkins.bak

🔧 2. 添加 Jenkins 官方 LTS Yum 源

sudo curl --silent --location https://pkg.jenkins.io/redhat-stable/jenkins.repo | sudo tee /etc/yum.repos.d/jenkins.repo > /dev/null

sudo rpm --import https://pkg.jenkins.io/redhat-stable/jenkins.io-2023.key

🔧 3. 升级 Jenkins

sudo yum clean all

sudo yum makecache

sudo yum upgrade jenkins -y

如果提示没有可升级的版本,执行以下命令强制重新安装最新版 Jenkins:

sudo yum remove jenkins -y

sudo yum install jenkins -y

⚠️ 不会丢失数据,因为 Jenkins 配置、任务、插件都在 /var/lib/jenkins 中,你已经备份过。

🔧 4. 启动 Jenkins 并查看状态

sudo systemctl daemon-reexec

sudo systemctl start jenkins

sudo systemctl status jenkins

🔧 5. 访问 Jenkins 页面

访问地址:

http://<你的服务器IP>:8888

🔧 6. 查看 Jenkins 新版本号

jenkins --version

或者登录网页右下角查看,应该是类似:

Jenkins ver. 2.440.1

查看 Jenkins 服务状态

请运行以下命令获取具体错误:

sudo systemctl status jenkins -l

步骤 3:重启 Jenkins 服务

sudo systemctl daemon-reexec

sudo systemctl restart jenkins

sudo systemctl status jenkins -l

🔗 插件下载地址与命令

以下命令会下载所有缺失依赖:

bash复制编辑# 进入 Jenkins 插件目录

cd /var/lib/jenkins/plugins

# 下载缺失的依赖插件

wget https://updates.jenkins.io/download/plugins/commons-lang3-api/3.13.0-62.v7d18e55f51e2/commons-lang3-api.hpi

wget https://updates.jenkins.io/download/plugins/ionicons-api/56.v1b_1c8c49374e/ionicons-api.hpi

wget https://updates.jenkins.io/download/plugins/caffeine-api/3.1.8-133.v17b_1ff2e0599/caffeine-api.hpi

持续集成环境—Jenkins插件管理【Manage Jenkins】

Jenkins本身不提供很多功能,我们可以通过使用插件来满足我们的使用。例如从Gitlab拉取代码,使用 Maven构建项目等功能需要依靠插件完成。接下来演示如何下载插件。

修改Jenkins插件下载地址

Jenkins国外官方插件地址下载速度非常慢,所以可以修改为国内插件地址:

Jenkins->Manage Jenkins->Manage Plugins,点击Available

新版本:Jenkins → Manage Jenkins → Plugins → Avaliable plugins

去Jenkins默认的开发目录

这样做是为了把 Jenkins官方的插件列表下载到本地,接着修改地址文件,替换为国内插件地址

[root@localhost sysconfig]# cd /var/lib/jenkins/

[root@localhost jenkins]# cd updates/

[root@localhost updates]# ll

总用量 3064

-rw-r–r–. 1 root root 3125621 6月 15 16:38 default.json

-rw-r–r–. 1 root root 7976 6月 15 16:38 hudson.tasks.Maven.MavenInstaller

sed -i ‘s/http://updates.jenkins ci.org/download/https://mirrors.tuna.tsinghua.edu.cn/jenkins/g’ default.json && sed -i ‘s/http:// www.google.com/https:\/\/ www.baidu.com/g' default.json

最后,Manage Plugins点击Advanced,把Update Site改为国内插件下载地址

https://mirrors.tuna.tsinghua.edu.cn/jenkins/updates/update-center.json

http://192.168.200.129:8888/restart 重启Jenkins

下载中文汉化插件

http://192.168.66.101:8888/restart ,重启Jenkins。 Jenkins->Manage Jenkins->Manage Plugins,点击Available,搜索”Chinese”

开启权限全局安全配置

在Security中的授权策略切换为 “Role-Based Strategy”,保存

【从插件市场上下载下来的 可以直接通过MobaXterm 放在/var/lib/jenkins/plugins/ 然后重启Jenkins】

创建角色

在系统管理页面进入 Manage and Assign Roles;点击”Manage Roles”

里面的Global roles(全局角色):管理员等高级用户可以创建基于全局的角色 Project roles(项目角色): 针对某个或者某些项目的角色 Slave roles(奴隶角色):节点相关的权限

我们添加以下三个角色:【一个基础角色 两个项目角色】

- baseRole :该角色为全局角色。这个角色需要绑定Overall下面的Read权限,是为了给所有用户绑 定最基本的Jenkins访问权限。注意:如果不给后续用户绑定这个角色,会报错误:用户名 is missing the Overall/Read permission

- role1 :该角色为项目角色(下面的Item roles)。使用正则表达式绑定” itcast.* “,意思是只能操作itcast开头的项目。

- role2 :该角色也为项目角色。绑定”itheima.*”,意思是只能操作itheima开头的项目。

创建用户

在系统管理页面进入 Manage Users

用户一:用户名:eric 密码:123456

用户二:用户名:JacK 密码:123456

给用户分配角色

系统管理页面进入Manage and Assign Roles,点击Assign Roles

绑定规则如下:

- eric 用户分别绑定baseRole和role1角色

- jack 用户分别绑定baseRole和role2角色

创建项目测试权限

以itcast管理员账户创建两个项目,分别为itcast01和itheima01

结果为:

- eric 用户登录,只能看到itcast01项目

- jack 用户登录,只能看到itheima01项目

持续集成环境—Jenkins凭证管理

凭据可以用来存储需要密文保护的数据库密码、Gitlab密码信息、Docker私有仓库密码等,以便 Jenkins可以和这些第三方的应用进行交互。

安装Credentials Binding插件

要在Jenkins使用凭证管理功能,需要安装Credentials Binding插件

安装插件后,左边多了”凭证“菜单,在这里管理所有凭证 [新版是在Security栏有凭证管理]

进入凭据后点击Stores scoped to Jenkins下 域的**全局**

可以添加的凭证有 5种:

- Username with password :用户名和密码

- SSH Username with private key: 使用SSH用户和密钥

- Secret file:需要保密的文本文件,使用时Jenkins会将文件复制到一个临时目录中,再将文件路径 设置到一个变量中,等构建结束后,所复制的Secret file就会被删除。

- Secret text :需要保存的一个加密的文本串,如钉钉机器人或Github的api token【k8s也会用】

- Certificate :通过上传证书文件的方式

常用的凭证类型有:Username with password(用户密码)和SSH Username with private key(SSH 密钥)

接下来以使用Git工具到Gitlab拉取项目源码为例,演示Jenkins的如何管理Gitlab的凭证

★ 在Jenkins里面安装git插件

★ 要先在Jenkins的服务里面安装git插件

CentOS7上安装Git工具:

yum install git -y 安装

git --version 安装后查看版本

用户密码类型

**全局添加凭证**:Dashboard → Manage Jenkins → Credentials → System → Global credentials (unrestricted) → New credentials

-

Jenkins->凭证->系统->全局凭证->添加凭证

测试凭证是否可用

创建一个FreeStyle项目:新建Item->FreeStyle Project->确定

找到 “源码管理”->”Git”,在Repository URL复制Gitlab中的项目URL

新搞个item然后点击进去 左侧的配置→General→源码管理→选择Git →↓

Repository URL:http://192.168.200.128:82/lanyun_group/web_demo.git

Credentials:【选择刚刚给张三创建的凭证】

保存配置后,点击构建 ”Build Now“ 开始构建项目

可以在左下方的Builds里找到刚刚构建的项目 可以查看控制台输出

Started by user root

Running as SYSTEM

Building in workspace /var/lib/jenkins/workspace/test02

The recommended git tool is: NONE

using credential ca22e56f-0ecc-4fdc-965d-01e329a0b68a

Cloning the remote Git repository

Cloning repository http://192.168.200.128:82/lanyun_group/web_demo.git

> git init /var/lib/jenkins/workspace/test02 # timeout=10

Fetching upstream changes from http://192.168.200.128:82/lanyun_group/web_demo.git

> git --version # timeout=10

> git --version # 'git version 1.8.3.1'

using GIT_ASKPASS to set credentials gitlab-auth-password

> git fetch --tags --progress http://192.168.200.128:82/lanyun_group/web_demo.git +refs/heads/*:refs/remotes/origin/* # timeout=10

> git config remote.origin.url http://192.168.200.128:82/lanyun_group/web_demo.git # timeout=10

> git config --add remote.origin.fetch +refs/heads/*:refs/remotes/origin/* # timeout=10

Avoid second fetch

> git rev-parse refs/remotes/origin/master^{commit} # timeout=10

Checking out Revision 2f41cd33af519a5c55df8d78ba59032d9069f0b8 (refs/remotes/origin/master)

> git config core.sparsecheckout # timeout=10

> git checkout -f 2f41cd33af519a5c55df8d78ba59032d9069f0b8 # timeout=10

Commit message: "初始化项目提交"

First time build. Skipping changelog.

Finished: SUCCESS

查看**/var/lib/jenkins/workspace/**目录,发现已经从Gitlab成功拉取了代码到Jenkins中

SSH密钥类型

SSH免密登录示意图:

[GitLab服务器(存放公钥:id_rsa.pub)] ←←←ssh免密登录←←← [Jenkins服务器(存放私钥:id_rsa)]

ssh-keygen -t rsa

在 192.168.200.129_Jenkins 服务器里

[root@localhost ~]# ssh-keygen -t rsa

Generating public/private rsa key pair.

Enter file in which to save the key (/root/.ssh/id_rsa):

Created directory '/root/.ssh'.

Enter passphrase (empty for no passphrase):

Enter same passphrase again:

Your identification has been saved in /root/.ssh/id_rsa.

Your public key has been saved in /root/.ssh/id_rsa.pub.

The key fingerprint is:

SHA256:88fFvAS2e6i9c4+KXfmENWeu6NJNmOb1+CCsYLarYLc root@localhost.localdomain

The key's randomart image is:

+---[RSA 2048]----+

| |

| |

| o |

| . = |

| S .o=.+|

| o o+=oBo|

| o . + .+B+Boo|

| . o + o.B+=+*.|

| E.o.+oB=oo+|

+----[SHA256]-----+

[root@localhost ~]# cd /root/.ssh

[root@localhost .ssh]# ll

总用量 8

-rw-------. 1 root root 1679 6月 18 20:05 id_rsa 【私钥】

-rw-r--r--. 1 root root 408 6月 18 20:05 id_rsa.pub 【公钥】

以root账户登录->点击头像->Settings->SSH Keys→在Jenkins服务里面用

[root@localhost .ssh]# cat id_rsa.pub

打开公钥的文件得到信息。复制刚才id_rsa.pub文件的内容到这里,点击”Add Key”

在Jenkins添加一个全局新的凭证,类型为”SSH Username with private key“,在jenkins服务器里输入指令查看私钥

[root@localhost .ssh]# cat id_rsa

把刚才生成私钥文件内容复制过来塞进去

此时去gitlab项目中把ssh的复制过来git@192.168.200.128:lanyun_group/web_demo.git

同样尝试构建项目,如果代码可以正常拉取,代表凭证配置成功!

如果报错:

Command "git ls-remote -h git@192.168.200.128:lanyun_group/web_demo.git HEAD" returned status code 128

stderr: No ECDSA host key is known for 192.168.200.128 and you have requested strict checking.

Host key verification failed.

fatal: Could not read from remote repository.

报错原因:

SSH 主机指纹未验证(Host key verification failed)

Git 使用的是 SSH 协议访问远程仓库(git@192.168.200.128),但本地机器之前没有连接过该主机,或者 .ssh/known_hosts 文件中没有该 IP 的公钥信息。

而且启用了“严格检查”(Strict Host Key Checking),所以 Git 拒绝连接该服务器。

★★ 方法:手动信任主机(推荐)★★

ssh git@192.168.200.128

系统会提示你是否信任该主机,比如:

The authenticity of host '192.168.200.128 (192.168.200.128)' can't be established.

ECDSA key fingerprint is SHA256:xxx...

Are you sure you want to continue connecting (yes/no/[fingerprint])?

✅ 输入 yes 之后,主机公钥会加入 ~/.ssh/known_hosts 文件,后续连接将不再失败。

到这里已经完成了这份图的部分内容,要开始融入Maven

持续集成环境—Maven安装和配置

在Jenkins集成服务器上,我们需要安装Maven来编译和打包项目

把apache-maven-3.6.2-bin.tar.gz传到 /root 根目录中【Jenkins服务器】

tar -xzf apache-maven-3.6.2-bin.tar.gz 解压

mkdir -p /opt/maven 创建目录

mv apache-maven-3.6.2/* /opt/maven 移动文件

[root@localhost ~]# mkdir -p /opt/maven

[root@localhost ~]# mv apache-maven-3.6.2/* /opt/maven

[root@localhost ~]# cd /opt/maven/

[root@localhost maven]# ll

总用量 28

drwxr-xr-x. 2 root root 97 6月 18 21:37 bin

drwxr-xr-x. 2 root root 42 6月 18 21:37 boot

drwxrwxr-x. 3 1000 mysql 63 8月 27 2019 conf

drwxrwxr-x. 4 1000 mysql 4096 6月 18 21:37 lib

-rw-rw-r–. 1 1000 mysql 12846 8月 27 2019 LICENSE

-rw-rw-r–. 1 1000 mysql 182 8月 27 2019 NOTICE

-rw-rw-r–. 1 1000 mysql 2533 8月 27 2019 README.txt

[root@localhost maven]#

配置环境变量

vi /etc/profile

export JAVA_HOME=/usr/local/java/jdk-17.0.8+7

export MAVEN_HOME=/opt/maven

export PATH=$PATH:$JAVA_HOME/bin:$MAVEN_HOME/bin

source /etc/profile 配置生效

mvn -v 查找Maven版本

全局工具配置关联JDK和Maven

Jenkins->Manage Jenkins->Tools→ JDK安装 → 新增JDK →

【JDK】

别名:jdk-17.0.8+7

JAVA_HOME:/usr/local/java/jdk-17.0.8+7

下面的Maven安装→ 新增Maven →

【Maven】

Name:maven3.6.2

MAVEN_HOME:/opt/maven

点击应用 → 保存

添加Jenkins全局变量

Jenkins → Manage Jenkins → System → 下面找到全局属性 → Environment variables

以下是用键值对的形式显示:

JAVA_HOME /usr/local/java/jdk-17.0.8+7

M2_HOME /opt/maven

PATH+EXTRA $M2_HOME/bin

修改Maven的settings.xml

mkdir /root/repo 创建本地仓库目录

vi /opt/maven/conf/settings.xml

本地仓库改为:/root/repo

<!-- localRepository

| The path to the local repository maven will use to store artifacts.

|

| Default: ${user.home}/.m2/repository

-->

<localRepository>/root/repo</localRepository>

添加阿里云私服地址:

<mirror>

<id>alimaven</id>

<name>aliyun maven</name>

<url>http://maven.aliyun.com/nexus/content/groups/public/</url>

<mirrorOf>central</mirrorOf>

</mirror>

测试Maven是否配置成功

使用之前的gitlab密码测试项目,修改配置;

在某个项目中→Triggers中→Build Steps选择 Execute shell(执行shell脚本命令)

输入

mvn clean package

然后再去构建!!

🔧 步骤一:删除损坏的插件文件

执行以下命令彻底删除这个错误的插件缓存:

rm -rf /root/repo/org/apache/maven/plugins/maven-clean-plugin

🔧 步骤二:将 Maven 镜像源改为稳定的中央仓库

编辑 /root/.m2/settings.xml 或 /etc/maven/settings.xml(按你的系统配置)为以下内容:

<settings xmlns="http://maven.apache.org/SETTINGS/1.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/SETTINGS/1.0.0

http://maven.apache.org/xsd/settings-1.0.0.xsd">

<localRepository>/root/repo</localRepository>

<mirrors>

<mirror>

<id>central</id>

<mirrorOf>*</mirrorOf>

<name>Maven Central</name>

<url>https://repo.maven.apache.org/maven2</url>

</mirror>

</mirrors>

</settings>

持续集成环境—Tomcat安装和配置

安装Tomcat8.5 把Tomcat压缩包上传到192.168.200.131服务器

yum install java-1.8.0-openjdk* -y 安装JDK(已完成)

tar -xzf apache-tomcat-8.5.47.tar.gz 解压

mkdir -p /opt/tomcat 创建目录

mv /root/apache-tomcat-8.5.47/* /opt/tomcat 移动文件

启动tomcat

/opt/tomcat/bin/startup.sh ★★

[Apache Tomcat/8.5.47] (http://192.168.200.131:8090/) 【已改端口8090】

关闭已有 Tomcat(建议先关闭,避免冲突):

/opt/tomcat/bin/shutdown.sh

再启动:

/opt/tomcat/bin/startup.sh

不过现在访问这个地址是没有权限的[403 Access Denied] (http://192.168.200.131:8090/manager/) 现在要增加权限

配置 Tomcat用户角色权限

默认情况下Tomcat是没有配置用户角色权限的

403 Access Denied

You are not authorized to view this page.

By default the Manager is only accessible from a browser running on the same machine as Tomcat. If you wish to modify this restriction, you’ll need to edit the Manager’s context.xml file.

If you have already configured the Manager application to allow access and you have used your browsers back button, used a saved book-mark or similar then you may have triggered the cross-site request forgery (CSRF) protection that has been enabled for the HTML interface of the Manager application. You will need to reset this protection by returning to the main Manager page. Once you return to this page, you will be able to continue using the Manager application’s HTML interface normally. If you continue to see this access denied message, check that you have the necessary permissions to access this application.

If you have not changed any configuration files, please examine the file conf/tomcat-users.xml in your installation. That file must contain the credentials to let you use this webapp.

For example, to add the manager-gui role to a user named tomcat with a password of s3cret, add the following to the config file listed above.

<role rolename="manager-gui"/>

<user username="tomcat" password="s3cret" roles="manager-gui"/>

Note that for Tomcat 7 onwards, the roles required to use the manager application were changed from the single manager role to the following four roles. You will need to assign the role(s) required for the functionality you wish to access.

manager-gui - allows access to the HTML GUI and the status pagesmanager-script - allows access to the text interface and the status pagesmanager-jmx - allows access to the JMX proxy and the status pagesmanager-status - allows access to the status pages only

The HTML interface is protected against CSRF but the text and JMX interfaces are not. To maintain the CSRF protection:

- Users with the

manager-gui role should not be granted either the manager-script or manager-jmx roles.

- If the text or jmx interfaces are accessed through a browser (e.g. for testing since these interfaces are intended for tools not humans) then the browser must be closed afterwards to terminate the session.

For more information - please see the Manager App How-To.

但是,后续Jenkins部署项目到Tomcat服务器,需要用到Tomcat的用户,所以修改tomcat以下配置, 添加用户及权限

vi /opt/tomcat/conf/tomcat-users.xml

内容如下:

<tomcat-users>

<role rolename="tomcat"/>

<role rolename="role1"/>

<role rolename="manager-script"/>

<role rolename="manager-gui"/>

<role rolename="manager-status"/>

<role rolename="admin-gui"/>

<role rolename="admin-script"/>

<user username="tomcat" password="tomcat" roles="manager-gui,manager

script,tomcat,admin-gui,admin-script"/>

</tomcat-users>

用户和密码都是: tomcat

注意:为了能够刚才配置的用户登录到Tomcat,还需要修改以下配置

vi /opt/tomcat/webapps/manager/META-INF/context.xml

<!--

<Valve className="org.apache.catalina.valves.RemoteAddrValve"

allow="127\.\d+\.\d+\.\d+|::1|0:0:0:0:0:0:0:1" />

-->

注释掉这行就行!!

关闭已有 Tomcat(建议先关闭,避免冲突):

/opt/tomcat/bin/shutdown.sh

再启动:

/opt/tomcat/bin/startup.sh

[/manager] (http://192.168.200.131:8090/manager/html) 此时就可以访问了!!!

3、Jenkins构建Maven项目

Jenkins项目构建类型(1)-Jenkins构建的项目类型介绍

Jenkins中自动构建项目的类型有很多,常用的有以下三种:

- 自由风格软件项目( FreeStyle Project)

- Maven 项目(Maven Project)

- 流水线项目( Pipeline Project)

每种类型的构建其实都可以完成一样的构建过程与结果,只是在操作方式、灵活度等方面有所区别,在 实际开发中可以根据自己的需求和习惯来选择。(PS:个人推荐使用流水线类型,因为灵活度非常高)

Jenkins项目构建类型(2)-自由风格项目构建

下面演示创建一个自由风格项目来完成项目的集成过程:

拉取代码→编译→打包→部署

……

部署

把项目部署到远程的Tomcat里面

1)安装 Deploy to container插件

Jenkins本身无法实现远程部署到Tomcat的功能,需要在Jenkins里面安装Deploy to container插件实现

Jenkins持续集成从入门到精通.pdf 【39页】

①:Build Steps → Execute shell →↓

echo "开始进行编译构建"

mvn clean package

echo "编译构建结束"

②:在Jenkins的项目配置里 下面

构建后操作:【Deploy war/ear to a container】→ 选择 Tomcat 8.x Remote

WAR/EAR files:target/*.war

Containers:

新增一个凭证 用户名tomcat 密码tomcat

部署成功后,访问项目:[演示项目主页] (http://192.168.200.131:8090/web_demo-1.0-SNAPSHOT/)

如果看到此页面,代表项目部署成功啦!--这是master分支 添加用户

修改用户

删除用户 查询用户

演示改动代码后的持续集成

1)IDEA中源码修改并提交到gitlab

2)在Jenkins中项目重新构建

3)访问Tomcat

演示改动代码后的持续集成

1)IDEA中源码修改并提交到gitlab

2)在Jenkins中项目重新构建

3)访问Tomcat

Jenkins项目构建类型(3)-Maven项目构建

1)安装 Maven Integration 插件

2)创建 Maven 项目

3)配置项目

拉取代码和远程部署的过程和自由风格项目一样,只是”构建”部分不同

新建Item → 构建一个maven项目

其中Build的Root POM是要找到pom.xml的路径才行【默认执行maven命令】

所以只需要在Goals and options里面敲上clean package

Jenkins项目构建类型(4)-Pipeline流水线项目构建(*)

Pipeline简介

1)概念

Pipeline,简单来说,就是一套运行在 Jenkins 上的工作流框架,将原来独立运行于单个或者多个节点 的任务连接起来,实现单个任务难以完成的复杂流程编排和可视化的工作。

2)使用Pipeline有以下好处(来自翻译自官方文档):

代码:Pipeline以代码的形式实现,通常被检入源代码控制,使团队能够编辑,审查和迭代其传送流 程。 持久:无论是计划内的还是计划外的服务器重启,Pipeline都是可恢复的。 可停止:Pipeline可接 收交互式输入,以确定是否继续执行Pipeline。 多功能:Pipeline支持现实世界中复杂的持续交付要 求。它支持fork/join、循环执行,并行执行任务的功能。 可扩展:Pipeline插件支持其DSL的自定义扩 展 ,以及与其他插件集成的多个选项。

3)如何创建 Jenkins Pipeline呢?

- Pipeline 脚本是由 Groovy 语言实现的,但是我们没必要单独去学习 Groovy

- Pipeline 支持两种语法:Declarative(声明式) 和 Scripted Pipeline(脚本式)语法

- Pipeline 也有两种创建方法:可以直接在 Jenkins 的 Web UI 界面中输入脚本;也可以通过创建一 个 Jenkinsfile 脚本文件放入项目源码库中(一般我们都推荐在 Jenkins 中直接从源代码控制(SCM) 中直接载入 Jenkinsfile Pipeline 这种方法)

安装Pipeline插件如果一次安装失败,重启一次再安装[没视图就安装pipeline Stage View]

Manage Jenkins->Manage Plugins->可选插件

Pipeline语法快速入门

1)Declarative声明式-Pipeline

创建项目 [agent是代理、stage是阶段、steps是步骤]

- Node :节点,一个 Node 就是一个 Jenkins 节点,Master 或者 Agent,是执行 Step 的具体运行 环境,后续讲到Jenkins的Master-Slave架构的时候用到。

- Stage :阶段,一个 Pipeline 可以划分为若干个 Stage,每个 Stage 代表一组操作,比如: Build、Test、Deploy,Stage 是一个逻辑分组的概念。

- Step :步骤,Step 是最基本的操作单元,可以是打印一句话,也可以是构建一个 Docker 镜像, 由各类 Jenkins 插件提供,比如命令:sh ‘make’,就相当于我们平时 shell 终端中执行 make 命令 一样。

pipeline {

agent any

stages {

stage('pull code') {

steps {

echo 'pull code'

}

}

stage('build project') {

steps {

echo 'build project'

}

}

stage('publish project') {

steps {

echo 'publish project'

}

}

}

}

2)Scripted Pipeline脚本式-Pipeline

创建项目

流水线那里选择 “Scripted Pipeline“

node {

def mvnHome

stage('pull code'){

echo 'pull code'

}

stage('build project'){

echo 'build project'

}

stage('publish project'){

echo 'publish project'

}

}

流水线脚本:点击可以使用官方的脚本生成器

- 片段生成器:

示例步骤:checkout:Check out from version control [从版本控制里拉取代码]

选择git拉取代码 填写URL和凭证 → 生成流水线脚本

拉取代码

Pipeline script

pipeline{

agent any

stages{

stage('拉取代码'){

steps{

checkout scmGit(branches: [[name: '*/master']], extensions: [], userRemoteConfigs: [[credentialsId: 'ca22e56f-0ecc-4fdc-965d-01e329a0b68a', url: 'http://192.168.200.132:82/lanyun_group/web_demo.git']])

}

}

}

}

Console Output

Started by user root

[Pipeline] Start of Pipeline

[Pipeline] node

Running on Jenkins in /var/lib/jenkins/workspace/web_demo_pipeline

[Pipeline] {

[Pipeline] stage

[Pipeline] { (拉取代码)

[Pipeline] checkout

The recommended git tool is: NONE

using credential ca22e56f-0ecc-4fdc-965d-01e329a0b68a

Cloning the remote Git repository

Cloning repository http://192.168.200.132:82/lanyun_group/web_demo.git

> git init /var/lib/jenkins/workspace/web_demo_pipeline # timeout=10

Fetching upstream changes from http://192.168.200.132:82/lanyun_group/web_demo.git

> git --version # timeout=10

> git --version # 'git version 1.8.3.1'

using GIT_ASKPASS to set credentials gitlab-auth-password

> git fetch --tags --progress http://192.168.200.132:82/lanyun_group/web_demo.git +refs/heads/*:refs/remotes/origin/* # timeout=10

> git config remote.origin.url http://192.168.200.132:82/lanyun_group/web_demo.git # timeout=10

> git config --add remote.origin.fetch +refs/heads/*:refs/remotes/origin/* # timeout=10

Avoid second fetch

> git rev-parse refs/remotes/origin/master^{commit} # timeout=10

Checking out Revision 7ae1ec4086586fb471b0e9dee0a0d00d0b6d6f54 (refs/remotes/origin/master)

> git config core.sparsecheckout # timeout=10

> git checkout -f 7ae1ec4086586fb471b0e9dee0a0d00d0b6d6f54 # timeout=10

Commit message: "修改index.jsp加入细节(!)"

First time build. Skipping changelog.

[Pipeline] }

[Pipeline] // stage

[Pipeline] }

[Pipeline] // node

[Pipeline] End of Pipeline

Finished: SUCCESS

去Jenkins的服务器里寻找/var/lib/jenkins/workspace/web_demo_pipeline

编译打包

流水线脚本:点击可以使用官方的脚本生成器

- 片段生成器:

示例步骤:sh:Shell Script

Shell Script:里面需要打所需要的命令 mvn clean package

Pipeline script

pipeline{

agent any

stages{

stage('build project'){

steps{

sh 'mvn clean package'

}

}

}

}

--------------------------------------------

【总流水线代码】

pipeline {

agent any

stages {

stage('pull code') {

steps {

checkout scmGit(

branches: [[name: '*/master']],

extensions: [],

userRemoteConfigs: [[

credentialsId: 'ca22e56f-0ecc-4fdc-965d-01e329a0b68a',

url: 'http://192.168.200.132:82/lanyun_group/web_demo.git'

]]

)

}

}

stage('build project') {

steps {

sh 'mvn clean package'

}

}

}

}

Console Output

Started by user root

[Pipeline] Start of Pipeline

[Pipeline] node

Running on Jenkins in /var/lib/jenkins/workspace/web_demo_pipeline

[Pipeline] {

[Pipeline] stage

[Pipeline] { (pull code)

[Pipeline] checkout

The recommended git tool is: NONE

using credential ca22e56f-0ecc-4fdc-965d-01e329a0b68a

> git rev-parse --resolve-git-dir /var/lib/jenkins/workspace/web_demo_pipeline/.git # timeout=10

Fetching changes from the remote Git repository

> git config remote.origin.url http://192.168.200.132:82/lanyun_group/web_demo.git # timeout=10

Fetching upstream changes from http://192.168.200.132:82/lanyun_group/web_demo.git

> git --version # timeout=10

> git --version # 'git version 1.8.3.1'

using GIT_ASKPASS to set credentials gitlab-auth-password

> git fetch --tags --progress http://192.168.200.132:82/lanyun_group/web_demo.git +refs/heads/*:refs/remotes/origin/* # timeout=10

> git rev-parse refs/remotes/origin/master^{commit} # timeout=10

Checking out Revision 7ae1ec4086586fb471b0e9dee0a0d00d0b6d6f54 (refs/remotes/origin/master)

> git config core.sparsecheckout # timeout=10

> git checkout -f 7ae1ec4086586fb471b0e9dee0a0d00d0b6d6f54 # timeout=10

Commit message: "修改index.jsp加入细节(!)"

> git rev-list --no-walk 7ae1ec4086586fb471b0e9dee0a0d00d0b6d6f54 # timeout=10

[Pipeline] }

[Pipeline] // stage

[Pipeline] stage

[Pipeline] { (build project)

[Pipeline] sh

+ mvn clean package

[INFO] Scanning for projects...

[INFO]

[INFO] ------------------------< com.itheima:web_demo >------------------------

[INFO] Building web_demo 1.0-SNAPSHOT

[INFO] --------------------------------[ war ]---------------------------------

[INFO]

[INFO] --- maven-clean-plugin:2.5:clean (default-clean) @ web_demo ---

[INFO]

[INFO] --- maven-resources-plugin:2.6:resources (default-resources) @ web_demo ---

[WARNING] Using platform encoding (UTF-8 actually) to copy filtered resources, i.e. build is platform dependent!

[INFO] skip non existing resourceDirectory /var/lib/jenkins/workspace/web_demo_pipeline/src/main/resources

[INFO]

[INFO] --- maven-compiler-plugin:3.8.1:compile (default-compile) @ web_demo ---

[INFO] Changes detected - recompiling the module!

[INFO] Compiling 1 source file to /var/lib/jenkins/workspace/web_demo_pipeline/target/classes

[INFO]

[INFO] --- maven-resources-plugin:2.6:testResources (default-testResources) @ web_demo ---

[WARNING] Using platform encoding (UTF-8 actually) to copy filtered resources, i.e. build is platform dependent!

[INFO] skip non existing resourceDirectory /var/lib/jenkins/workspace/web_demo_pipeline/src/test/resources

[INFO]

[INFO] --- maven-compiler-plugin:3.8.1:testCompile (default-testCompile) @ web_demo ---

[INFO] No sources to compile

[INFO]

[INFO] --- maven-surefire-plugin:2.12.4:test (default-test) @ web_demo ---

[INFO] No tests to run.

[INFO]

[INFO] --- maven-war-plugin:3.3.2:war (default-war) @ web_demo ---

[INFO] Packaging webapp

[INFO] Assembling webapp [web_demo] in [/var/lib/jenkins/workspace/web_demo_pipeline/target/web_demo-1.0-SNAPSHOT]

[INFO] Processing war project

[INFO] Copying webapp resources [/var/lib/jenkins/workspace/web_demo_pipeline/src/main/webapp]

[INFO] Building war: /var/lib/jenkins/workspace/web_demo_pipeline/target/web_demo-1.0-SNAPSHOT.war

[INFO] ------------------------------------------------------------------------

[INFO] BUILD SUCCESS

[INFO] ------------------------------------------------------------------------

[INFO] Total time: 10.242 s

[INFO] Finished at: 2025-06-24T20:32:45+08:00

[INFO] ------------------------------------------------------------------------

[Pipeline] }

[Pipeline] // stage

[Pipeline] }

[Pipeline] // node

[Pipeline] End of Pipeline

Finished: SUCCESS

部署

流水线脚本:点击可以使用官方的脚本生成器

- 片段生成器:

示例步骤:deploy:Deploy war/ear to a container

WAR/EAR files:target/*.war

containers:Tomcat 8.x Remote 【容器可以增加多台】

credentials:添加tomcat凭证

Tomcat URL:http://192.168.200.131:8090/

Pipeline script

【总流水线代码】

pipeline {

agent any

stages {

stage('pull code') {

steps {

checkout scmGit(

branches: [[name: '*/master']],

extensions: [],

userRemoteConfigs: [[

credentialsId: 'ca22e56f-0ecc-4fdc-965d-01e329a0b68a',

url: 'http://192.168.200.132:82/lanyun_group/web_demo.git'

]]

)

}

}

stage('build project') {

steps {

sh 'mvn clean package'

}

}

stage('publish') {

steps {

deploy adapters: [tomcat8(alternativeDeploymentContext: '', credentialsId: 'e847a130-29c3-4d0b-bf35-db8d00de7950', path: '', url: 'http://192.168.200.131:8090/')], contextPath: null, war: 'target/*.war'

}

}

}

}

Console Output

Started by user root

[Pipeline] Start of Pipeline

[Pipeline] node

Running on Jenkins in /var/lib/jenkins/workspace/web_demo_pipeline

[Pipeline] {

[Pipeline] stage

[Pipeline] { (pull code)

[Pipeline] checkout

The recommended git tool is: NONE

using credential ca22e56f-0ecc-4fdc-965d-01e329a0b68a

> git rev-parse --resolve-git-dir /var/lib/jenkins/workspace/web_demo_pipeline/.git # timeout=10

Fetching changes from the remote Git repository

> git config remote.origin.url http://192.168.200.132:82/lanyun_group/web_demo.git # timeout=10

Fetching upstream changes from http://192.168.200.132:82/lanyun_group/web_demo.git

> git --version # timeout=10

> git --version # 'git version 1.8.3.1'

using GIT_ASKPASS to set credentials gitlab-auth-password

> git fetch --tags --progress http://192.168.200.132:82/lanyun_group/web_demo.git +refs/heads/*:refs/remotes/origin/* # timeout=10

> git rev-parse refs/remotes/origin/master^{commit} # timeout=10

Checking out Revision 7ae1ec4086586fb471b0e9dee0a0d00d0b6d6f54 (refs/remotes/origin/master)

> git config core.sparsecheckout # timeout=10

> git checkout -f 7ae1ec4086586fb471b0e9dee0a0d00d0b6d6f54 # timeout=10

Commit message: "修改index.jsp加入细节(!)"

> git rev-list --no-walk 7ae1ec4086586fb471b0e9dee0a0d00d0b6d6f54 # timeout=10

[Pipeline] }

[Pipeline] // stage

[Pipeline] stage

[Pipeline] { (build project)

[Pipeline] sh

+ mvn clean package

[INFO] Scanning for projects...

[INFO]

[INFO] ------------------------< com.itheima:web_demo >------------------------

[INFO] Building web_demo 1.0-SNAPSHOT

[INFO] --------------------------------[ war ]---------------------------------

[INFO]

[INFO] --- maven-clean-plugin:2.5:clean (default-clean) @ web_demo ---

[INFO] Deleting /var/lib/jenkins/workspace/web_demo_pipeline/target

[INFO]

[INFO] --- maven-resources-plugin:2.6:resources (default-resources) @ web_demo ---

[WARNING] Using platform encoding (UTF-8 actually) to copy filtered resources, i.e. build is platform dependent!

[INFO] skip non existing resourceDirectory /var/lib/jenkins/workspace/web_demo_pipeline/src/main/resources

[INFO]

[INFO] --- maven-compiler-plugin:3.8.1:compile (default-compile) @ web_demo ---

[INFO] Changes detected - recompiling the module!

[INFO] Compiling 1 source file to /var/lib/jenkins/workspace/web_demo_pipeline/target/classes

[INFO]

[INFO] --- maven-resources-plugin:2.6:testResources (default-testResources) @ web_demo ---

[WARNING] Using platform encoding (UTF-8 actually) to copy filtered resources, i.e. build is platform dependent!

[INFO] skip non existing resourceDirectory /var/lib/jenkins/workspace/web_demo_pipeline/src/test/resources

[INFO]

[INFO] --- maven-compiler-plugin:3.8.1:testCompile (default-testCompile) @ web_demo ---

[INFO] No sources to compile

[INFO]

[INFO] --- maven-surefire-plugin:2.12.4:test (default-test) @ web_demo ---

[INFO] No tests to run.

[INFO]

[INFO] --- maven-war-plugin:3.3.2:war (default-war) @ web_demo ---

[INFO] Packaging webapp

[INFO] Assembling webapp [web_demo] in [/var/lib/jenkins/workspace/web_demo_pipeline/target/web_demo-1.0-SNAPSHOT]

[INFO] Processing war project

[INFO] Copying webapp resources [/var/lib/jenkins/workspace/web_demo_pipeline/src/main/webapp]

[INFO] Building war: /var/lib/jenkins/workspace/web_demo_pipeline/target/web_demo-1.0-SNAPSHOT.war

[INFO] ------------------------------------------------------------------------

[INFO] BUILD SUCCESS

[INFO] ------------------------------------------------------------------------

[INFO] Total time: 7.472 s

[INFO] Finished at: 2025-06-24T20:39:46+08:00

[INFO] ------------------------------------------------------------------------

[Pipeline] }

[Pipeline] // stage

[Pipeline] stage

[Pipeline] { (publish)

[Pipeline] deploy

[DeployPublisher][INFO] Attempting to deploy 1 war file(s)

[DeployPublisher][INFO] Deploying /var/lib/jenkins/workspace/web_demo_pipeline/target/web_demo-1.0-SNAPSHOT.war to container Tomcat 8.x Remote with context null

Redeploying [/var/lib/jenkins/workspace/web_demo_pipeline/target/web_demo-1.0-SNAPSHOT.war]

Undeploying [/var/lib/jenkins/workspace/web_demo_pipeline/target/web_demo-1.0-SNAPSHOT.war]

Deploying [/var/lib/jenkins/workspace/web_demo_pipeline/target/web_demo-1.0-SNAPSHOT.war]

[Pipeline] }

[Pipeline] // stage

[Pipeline] }

[Pipeline] // node

[Pipeline] End of Pipeline

Finished: SUCCESS

Pipeline Script from SCM

刚才我们都是直接在Jenkins的UI界面编写Pipeline代码,这样不方便脚本维护,建议把Pipeline脚本放 在项目中(一起进行版本控制)

1)在项目根目录建立Jenkinsfile文件,把内容复制到该文件中。把Jenkinsfile上传到Gitlab

Jenkinsfile【在根目录下】

pipeline {

agent any

stages {

stage('pull code') {

steps {

checkout scmGit(

branches: [[name: '*/master']],

extensions: [],

userRemoteConfigs: [[

credentialsId: 'ca22e56f-0ecc-4fdc-965d-01e329a0b68a',

url: 'http://192.168.200.132:82/lanyun_group/web_demo.git'

]]

)

}

}

stage('build project') {

steps {

sh 'mvn clean package'

}

}

stage('publish') {

steps {

deploy adapters: [tomcat8(alternativeDeploymentContext: '', credentialsId: 'e847a130-29c3-4d0b-bf35-db8d00de7950', path: '', url: 'http://192.168.200.131:8090/')], contextPath: null, war: 'target/*.war'

}

}

}

}

2)在项目中引用该文件

在流水线上

定义Pipeline script from SCM → 选择git → 填写gitlab的url和凭证 → 脚本路径Jenkinsfile(这是我们上传的jenkinsfile里面包含着流水线代码的文件)

Jenkins项目构建细节(1)-常用的构建触发器

Jenkins内置4种构建触发器:

- 触发远程构建

- 其他工程构建后触发( Build after other projects are build)

- 定时构建( Build periodically)

- 轮询 SCM(Poll SCM)

触发远程构建

打开web_demo_pipeline的配置 里面的Triggers 选择触发远程构建 身份验证令牌(这个token最好是加密的) 下面有个触发地址:

Use the following URL to trigger build remotely: JENKINS_URL/job/web_demo_pipeline/build?token=TOKEN_NAME 或者 /buildWithParameters?token=TOKEN_NAME

Optionally append &cause=Cause+Text to provide text that will be included in the recorded build cause.

上面地址里面的:job/web_demo_pipeline/build?token=TOKEN_NAME

→ http://192.168.200.129:8888/job/web_demo_pipeline/build?token=6666

在浏览器输入上述地址 回车打开 你会发现已经远程触发了Jenkins的构建行为!!

其他工程构建后触发

1)创建pre_job流水线工程

2)配置需要触发的工程

打开web_demo_pipeline的配置 里面的Triggers 选择Build after other projects are built

新建item → 创建一个pre_job的自由风格的工程 → 构建Execute shell 执行一个简单的脚本

回到web_demo_pipeline工程 在Triggers里面选择前置工程pre_job

此时去构建pre_job你会发现 在构建完后 web_demo_pipeline也会进行自动构建

定时构建

定时字符串从左往右分别为: 分 时 日 月 周

一些定时表达式的例子:(H为0 就为整点)

每30分钟构建一次:H代表形参 H/30 * * * * 10:02 10:32

每2个小时构建一次: H H/2 * * *

每天的8点,12点,22点,一天构建3次: (多个时间点中间用逗号隔开) 0 8,12,22 * * *

每天中午12点定时构建一次 H 12 * * *

每天下午18点定时构建一次 H 18 * * *

在每个小时的前半个小时内的每10分钟 H(0-29)/10 * * * *

每两小时一次,每个工作日上午9点到下午5点(也许是上午10:38,下午12:38,下午2:38,下午

4:38) H H(9-16)/2 * * 1-5

打开web_demo_pipeline的配置 里面的Triggers 选择 Build periodically 然后可以写时间cron表达式即可

轮询SCM [版本控制] [企业级不推荐使用]

轮询SCM,是指定时扫描本地代码仓库的代码是否有变更,如果代码有变更就触发项目构建。

打开web_demo_pipeline的配置 里面的Triggers 选择Poll SCM

jenkins的轮询SCM的构建到底是远程仓库变动触发 还是 本地仓库变动触发?

Jenkins 的“轮询 SCM”是通过轮询远程 Git 仓库(如 GitLab、GitHub)判断是否有变更,从而决定是否触发构建。

注意:这次构建触发器, Jenkins会定时扫描整个项目的代码,增大系统的开销,不建议使用。

Jenkins项目构建细节(2)-Git hook自动触发构建(*)gitlab就用gitlab插件,github则是github插件

先在Jenkins市场安装gitlab插件

刚才我们看到在Jenkins的内置构建触发器中,轮询SCM可以实现Gitlab代码更新,项目自动构建,但是 该方案的性能不佳。那有没有更好的方案呢? 有的。就是利用Gitlab的webhook实现代码push到仓 库,立即触发项目自动构建。

轮询SCM原理:Jenkins →(发送定时请求)→ Gitlab代码变更

webhook原理:Gitlab代码变更 →(发送构建请求)→ Jenkins

打开web_demo_pipeline的配置 里面的Triggers 选择Build when a change is pushed to GitLab. GitLab webhook URL: http://192.168.200.129:8888/project/web_demo_pipeline

★ 要用root账号去GitLab开通一个webhook规则 → 点击上方的小齿轮 → 右侧Settings → Network → 展开Outbound requests → 勾选Allow requests to the local network from web hooks and services和Allow requests to the local network from system hooks保存 → 在web_demo项目中 → Settings → Integrations → 可以粘贴URL(这里就是在Jenkins里面的http://192.168.200.129:8888/project/web_demo_pipeline) [把代码push到项目里来就会触发这个url自动构建] → Add webhook → 下方可以进行测试test → push event →↓

若出现 则证明gitlab是成功 只是Jenkins需要认证请求 去Jenkins开放接收请求的功能

Hook executed successfully but returned HTTP 403 <html> <head> <meta http-equiv="Content-Type" content="text/html;charset=ISO-8859-1"/> <title>Error 403 anonymous is missing the Job/Build permission</title> </head> <body><h2>HTTP ERROR 403 anonymous is missing the Job/Build permission</h2> <table> <tr><th>URI:</th><td>/project/web_demo_pipeline</td></tr> <tr><th>STATUS:</th><td>403</td></tr> <tr><th>MESSAGE:</th><td>anonymous is missing the Job/Build permission</td></tr> <tr><th>SERVLET:</th><td>Stapler</td></tr> </table> <hr/><a href="https://jetty.org/">Powered by Jetty:// 12.0.19</a><hr/> </body> </html>

Jenkins开放接收请求 → 打开主页并跟随路径Dashboard → Manage Jenkins → System 找到 GitLab Enable authentication for ‘/project’ end-point【这个要反选 就是不能选钩 且里面的东西删除】 → 再去进行测试test → push event 即可成功Hook executed successfully: HTTP 200

Jenkins项目构建细节(3)-Jenkins的参数化构建

有时在项目构建的过程中,我们需要**根据用户的输入动态传入一些参数**,从而影响整个构建结果,这时 我们可以使用参数化构建。

Jenkins支持非常丰富的参数类型

大概意思就是 我在项目的jenkinsfile文件里面

steps {

checkout scmGit(

branches: [[name: ‘*/master’]],

extensions: [],

userRemoteConfigs: [[

credentialsId: ‘ca22e56f-0ecc-4fdc-965d-01e329a0b68a’,

url: ‘http://192.168.200.132:82/lanyun_group/web_demo.git'

]]

)

这个branches里面的 */master我要求是让用户动态输入值 而不是写死

首先要在项目里面增加一些参数 web_demo_pipeline 项目中 可以先把触发器的值取消掉 → 进入上面的General的配置 选择This project is parameterized → 可以添加参数 → 加入String Parameter参数 →

输入 名称:branch,默认值:master,描述:请输入一个分支的名称 → 此时在左侧就会出现一个 Build with Parameters →↓

pipeline {

agent any

stages {

stage(‘pull code’) {

steps {

checkout scmGit(

branches: [[name: ‘/${branch}}’]],

extensions: [],

userRemoteConfigs: [[

credentialsId: ‘ca22e56f-0ecc-4fdc-965d-01e329a0b68a’,

url: ‘http://192.168.200.132:82/lanyun_group/web_demo.git'

]]

)

}

}

stage(‘build project’) {

steps {

sh ‘mvn clean package’

}

}

stage(‘publish’) {

steps {

deploy adapters: [tomcat8(alternativeDeploymentContext: ‘’, credentialsId: ‘e847a130-29c3-4d0b-bf35-db8d00de7950’, path: ‘’, url: ‘http://192.168.200.131:8090/')], contextPath: null, war: ‘target/.war’

}

}

}

}

【这时你在Jenkins构建时输入的参数就可以对应着Jenkinsfile文件的动态参数进行构建 (动态值红色已标注)】→ 需要把jenkinsfile的代码push到仓库里去

Jenkins项目构建细节(4)-配置邮箱服务器发送构建结果

安装Email Extension Template插件

Jenkins设置邮箱相关参数

Dashboard → Manage Jenkins → System → Extended E-mail Notification → QQ邮箱【官网 账号安全设置】打开SMTP服务 找到 POP3/SMTP服务,点击「开启」→ 勾选“开启服务”旁边的复选框 → 生成SMTP/IMAP 授权码已生成 → jitgujalhqtecadc → 回到Jenkins → SMTP server填写:smtp.qq.com;端口是465 → Default user e-mail suffix:@qq.com 下面的用户名是发件人 密码是授权码 使用SSL协议的话SMTP端口就是465 → Jenkins Location 系统管理员邮件地址是发件人地址

准备邮件内容

在项目根目录编写email.html,并把文件推送到Gitlab,内容如下:【根目录下】

BUILD_NUMBER、BUILD_STATUS等 来自于Jenkins的全局变量

<!DOCTYPE html>

<html>

<head>

<meta charset="UTF-8">

<title>${ENV, var="JOB_NAME"}-第${BUILD_NUMBER}次构建日志</title>

</head>

<body leftmargin="8" marginwidth="0" topmargin="8" marginheight="4"

offset="0">

<table width="95%" cellpadding="0" cellspacing="0"

style="font-size: 11pt; font-family: Tahoma, Arial, Helvetica, sans-serif">

<tr>

<td>(本邮件是程序自动下发的,请勿回复!)</td>

</tr>

<tr>

<td><h2>

<font color="#0000FF">构建结果 - ${BUILD_STATUS}</font>

</h2></td>

</tr>

<tr>

<td><br />

<b><font color="#0B610B">构建信息</font></b>

<hr size="2" width="100%" align="center" /></td>

</tr>

<tr>

<td>

<ul>

<li>项目名称 : ${PROJECT_NAME}</li>

<li>构建编号 : 第${BUILD_NUMBER}次构建</li>

<li>触发原因: ${CAUSE}</li>

<li>构建日志: <a href="${BUILD_URL}console">${BUILD_URL}console</a></li>

<li>构建 Url : <a href="${BUILD_URL}">${BUILD_URL}</a></li>

<li>工作目录 : <a href="${PROJECT_URL}ws">${PROJECT_URL}ws</a></li>

<li>项目 Url : <a href="${PROJECT_URL}">${PROJECT_URL}</a></li>

</ul>

</td>

</tr>

<tr>

<td><b><font color="#0B610B">Changes Since Last

Successful Build:</font></b>

<hr size="2" width="100%" align="center" /></td>

</tr>

<tr>

<td>

<ul>

<li>历史变更记录 : <a href="${PROJECT_URL}changes">${PROJECT_URL}changes</a></li>

</ul> ${CHANGES_SINCE_LAST_SUCCESS,reverse=true, format="Changes for Build #%n:<br />%c<br />",showPaths=true,changesFormat="<pre>[%a]<br />%m</pre>",pathFormat=" %p"}

</td>

</tr>

<tr>

<td><b>Failed Test Results</b>

<hr size="2" width="100%" align="center" /></td>

</tr>

<tr>

<td><pre

style="font-size: 11pt; font-family: Tahoma, Arial, Helvetica, sans-serif">$FAILED_TESTS</pre>

<br /></td>

</tr>

<tr>

<td><b><font color="#0B610B">构建日志 (最后 100行):</font></b>

<hr size="2" width="100%" align="center" /></td>

</tr>

<tr>

<td><textarea cols="80" rows="30" readonly="readonly"

style="font-family: Courier New">${BUILD_LOG, maxLines=100}</textarea>

</td>

</tr>

</table>

</body>

</html>

post的内容可以用流水线语法生成 → 完成之后点击片段生成器 生成一个 emailext: Extended Email 的代码片段

pipeline {

agent any

stages {

stage('pull code') {

steps {

checkout scmGit(

branches: [[name: '*/${branch}']],

extensions: [],

userRemoteConfigs: [[

credentialsId: 'ca22e56f-0ecc-4fdc-965d-01e329a0b68a',

url: 'http://192.168.200.132:82/lanyun_group/web_demo.git'

]]

)

}

}

stage('build project') {

steps {

sh 'mvn clean package'

}

}

stage('publish') {

steps {

deploy adapters: [tomcat8(alternativeDeploymentContext: '', credentialsId: 'e847a130-29c3-4d0b-bf35-db8d00de7950', path: '', url: 'http://192.168.200.131:8090/')], contextPath: null, war: 'target/*.war'

}

}

}

post{

always{

emailext(

subject: '构建通知:${PROJECT_NAME} - Build # ${BUILD_NUMBER} - ${BUILD_STATUS}!',

body: '${FILE,path="email.html"}',

to: '2523419709@qq.com'

)

}

}

}

PS:邮件相关全局参数参考列表:

系统设置->Extended E-mail Notification->Content Token Reference,点击旁边的?号

Jenkins+SonarQube代码审查(1) - 安装SonarQube

SonaQube简介

SonarQube 是一个用于管理代码质量的开放平台,可以快速的定位代码中潜在的或者明显的错误。目前 支持java,C#,C/C++,Python,PL/SQL,Cobol,JavaScrip,Groovy等二十几种编程语言的代码质量管理与检 测。

官网: https://www.sonarqube.org/

环境要求

| 软件 |

服务器 |

版本 |

| JDK |

192.168.200.129 |

1.8 |

| MySQL |

192.168.200.129 |

5.7 |

| SonarQube |

192.168.200.129 |

6.7.4 |

安装SonarQube

1)安装MySQL(已完成)

2)安装SonarQube

使用5.7数据库

先删除以前的

建议操作:

- 先把多余或冲突的文件临时备份移动一下,避免yum混乱

bash复制编辑sudo mv /etc/yum.repos.d/mysql-community.repo.rpmsave /root/

sudo mv /etc/yum.repos.d/mysql57.repo /root/

- 只保留

mysql-community.repo 这个 repo 文件,确保它内容正确(你可以用cat看下内容)

cat /etc/yum.repos.d/mysql-community.repo

- 清理缓存,重新生成

sudo yum clean all

sudo yum makecache

- 尝试安装mysql 5.7

sudo yum install mysql-community-server

解决方案:用符合策略的密码先改,再降低策略

- 用一个符合复杂度的密码先改密码,例如:

sql

复制编辑

ALTER USER 'root'@'localhost' IDENTIFIED BY 'Root@12345';

- 登录成功后降低密码策略:

sql复制编辑SET GLOBAL validate_password_policy=LOW;

SET GLOBAL validate_password_length=1;

- 再修改为你想要的简单密码(比如

root):

sql

复制编辑

ALTER USER 'root'@'localhost' IDENTIFIED BY 'root';

- 刷新权限

FLUSH PRIVILEGES;

在mysql创建sonar数据库

启动 MySQL 服务(如果没启动)

systemctl start mysqld

启动后再次检查状态:

systemctl status mysqld

mysql -uroot -p

账号密码是:root

mysql> create database sonar;

mysql> show databases;

+--------------------+

| Database |

+--------------------+

| information_schema |

| mysql |

| performance_schema |

| sonar |

| sys |

+--------------------+

5 rows in set (0.07 sec)

解压sonar,并设置权限

yum install unzip

unzip sonarqube-6.7.4.zip 解压

mkdir /opt/sonar 创建目录

mv sonarqube-6.7.4/* /opt/sonar 移动文件

useradd sonar 创建sonar用户,必须sonar用于启动,否则报错

chown -R sonar. /opt/sonar 更改sonar目录及文件权限

[root@localhost ~]# cd /opt/sonar

[root@localhost sonar]# ll

总用量 12

drwxr-xr-x. 8 sonar sonar 136 5月 30 2018 bin

drwxr-xr-x. 2 sonar sonar 50 5月 30 2018 conf

-rw-r–r–. 1 sonar sonar 7651 5月 30 2018 COPYING

drwxr-xr-x. 2 sonar sonar 24 5月 30 2018 data

drwxr-xr-x. 7 sonar sonar 150 5月 30 2018 elasticsearch

drwxr-xr-x. 4 sonar sonar 40 5月 30 2018 extensions

drwxr-xr-x. 9 sonar sonar 140 5月 30 2018 lib

drwxr-xr-x. 2 sonar sonar 6 5月 30 2018 logs

drwxr-xr-x. 2 sonar sonar 24 5月 30 2018 temp

drwxr-xr-x. 9 sonar sonar 4096 5月 30 2018 web

修改sonar配置文件数据库连接信息

[root@localhost opt]# cd sonar

[root@localhost sonar]# cd conf

[root@localhost conf]# vi sonar.properties

|| || || ||

......

sonar.jdbc.username=root

sonar.jdbc.password=root

......

sonar.jdbc.url=jdbc:mysql://127.0.0.1:3306/sonar?useUnicode=true&characterEncoding=utf8&rewriteBatchedStatements=true&useConfigs=maxPerformance&useSSL=false 【这里打开注释】

注意:sonar默认监听9000端口,如果9000端口被占用,需要更改

如果要改端口 在这里:

sonar.web.port=9999

启动sonar 129

[root@localhost bin]# pwd

/opt/sonar/bin

cd /opt/sonar/bin

修改配置文件:vi /opt/sonar/conf/sonar.properties

重启sonar:sudo -u sonar /opt/sonar/bin/linux-x86-64/sonar.sh restart ★★ [Jenkins服务]

实时跟踪最新日志输出(推荐用于调试启动或运行时状态)

tail -f /opt/sonar/logs/sonar.log

tail -f /opt/sonar/logs/web.log

tail -f /opt/sonar/logs/es.log

查看日志末尾100条内容(快速查看最近日志)

tail -n 100 /opt/sonar/logs/sonar.log

tail -n 100 /opt/sonar/logs/web.log

tail -n 100 /opt/sonar/logs/es.log

查看整个日志文件大小和权限

ls -lh /opt/sonar/logs/*.log

访问SonarQube

[192.168.200.129] (http://192.168.200.129:9999/)

账号密码:admin admin

生成了一个token:sonar: d30033c63973bd4183b6015995dbb513627c6f59

启动命令总结:

[192.168.200.132] GitLab:gitlab-ctl restart

lanyun_group / web_demo · GitLab

[192.168.200.131] Tomcat:/opt/tomcat/bin/startup.sh

演示项目主页

[192.168.200.129] Jenkins:systemctl start jenkins

登录 - Jenkins

[192.168.200.129] SonarQube:sudo -u sonar /opt/sonar/bin/linux-x86-64/sonar.sh restart

192.168.200.129

Jenkins+SonarQube代码审查(2) - 实现代码审查

审查流程:

Jenkins →(调用)→ Sonar-Scanner →(提交审查结果)→ SonarQube →(保存审查结果)→ MySQL数据库

安装SonarQube Scanner插件

打开Jenkins的全局配置 → SonarQube Servers → Add SonarQube → Name:sonarqube;Server URL:http://192.168.200.129:9999/ → 新建一个证书[Manage Jenkins → Credentials → System → 全局添加 → 类型选择Secret text ;Secret是之前复制到的token字符串 ;描述:sonarqube-auth] → Server authentication token选择刚刚创建的sonarqube-auth

SonarQube 关闭审查结果上传到SCM功能

[General Settings - Administration] (http://192.168.200.129:9999/admin/settings?category=scm) 上方的Administration → 左侧的SCM → 第一个打开SCN Sensor

回到Jenkins的web_demo_freestyle项目点击构建 下方的Build Steps下面的增加构建步骤 选择Execute SonarQube Scanner (这里要在去Tools里安装配置 SonarQube Scanner 安装 → Name:sonar-scanner;Install automatically:SonarQube Scanner 4.2.0.1873) → 这里的jdk是根据Jenkins的jdk配置的 → (Path to project properties这个可以在项目下搞 也可以用Analysis properties 属性放在前端ui界面里面) 这里选择Analysic properties→↓

# must be unique in a given SonarQube instance

sonar.projectKey=web_demo_freestyle

# this is the name and version displayed in the SonarQube UI. Was mandatory

prior to SonarQube 6.1.

sonar.projectName=web_demo_freestyle

sonar.projectVersion=1.0

# Path is relative to the sonar-project.properties file. Replace "\" by "/" on

Windows.

# This property is optional if sonar.modules is set.

sonar.sources=.

sonar.exclusions=**/test/**,**/target/**

sonar.java.source=1.8

sonar.java.target=1.8

# Encoding of the source code. Default is default system encoding

sonar.sourceEncoding=UTF-8

→ 应用保存 + 重新构建

现在有个问题就是我Jenkins是2.504.2 然后jdk是17 我不想换jdk的情况下就要去

Build Steps里面的执行脚本

echo "开始进行编译构建"

mvn clean package

echo "编译构建结束"

# 设置环境变量,给sonar-scanner的JVM传参数,解决Java17模块访问问题

export SONAR_SCANNER_OPTS="--add-opens=java.base/java.lang=ALL-UNNAMED \

--add-opens=java.base/java.lang.reflect=ALL-UNNAMED \

--add-opens=java.base/java.io=ALL-UNNAMED"

# 执行Sonar扫描

/var/lib/jenkins/tools/hudson.plugins.sonar.SonarRunnerInstallation/sonar-scanner/bin/sonar-scanner \

-Dsonar.projectKey=web_demo_freestyle \

-Dsonar.host.url=http://192.168.200.129:9999 \

-Dsonar.sources=. \

-Dsonar.exclusions=**/test/**,**/target/** \

-Dsonar.java.source=1.8 \

-Dsonar.java.target=1.8

echo "SonarQube扫描结束"

打开idea jenkinsfile文件

pipeline {

agent any

stages {

stage('pull code') {

steps {

checkout scmGit(

branches: [[name: "*/${branch}"]],

extensions: [],

userRemoteConfigs: [[

credentialsId: 'ca22e56f-0ecc-4fdc-965d-01e329a0b68a',

url: 'http://192.168.200.132:82/lanyun_group/web_demo.git'

]]

)

}

}

stage('build project') {

steps {

sh 'mvn clean package'

}

}

stage('sonarqube scan') {

environment {

// 传递给sonar-scanner JVM的启动参数,解决模块访问限制

SONAR_SCANNER_OPTS = '--add-opens=java.base/java.lang=ALL-UNNAMED ' +

'--add-opens=java.base/java.lang.reflect=ALL-UNNAMED ' +

'--add-opens=java.base/java.io=ALL-UNNAMED'

}

steps {

sh '''

/var/lib/jenkins/tools/hudson.plugins.sonar.SonarRunnerInstallation/sonar-scanner/bin/sonar-scanner \

-Dsonar.projectKey=web_demo_freestyle \

-Dsonar.host.url=http://192.168.200.129:9999 \

-Dsonar.sources=. \

-Dsonar.exclusions=**/test/**,**/target/** \

-Dsonar.java.source=1.8 \

-Dsonar.java.target=1.8

'''

}

}

stage('publish') {

steps {

deploy adapters: [tomcat8(

alternativeDeploymentContext: '',

credentialsId: 'e847a130-29c3-4d0b-bf35-db8d00de7950',

path: '',

url: 'http://192.168.200.131:8090/'

)], contextPath: null, war: 'target/*.war'

}

}

}

post {

always {

emailext(

subject: '构建通知:${PROJECT_NAME} - Build # ${BUILD_NUMBER} - ${BUILD_STATUS}!',

body: '${FILE,path="email.html"}',

to: '2523419709@qq.com'

)

}

}

}

✅ 方法一:编辑 SonarScanner 的配置文件(最可靠)

编辑 Jenkins 中自动下载的 sonar-scanner 的 JVM 启动参数配置文件:

sudo vi /var/lib/jenkins/tools/hudson.plugins.sonar.SonarRunnerInstallation/sonar-scanner/conf/sonar-scanner.properties

在文件最后 添加

# 开启JDK17对反射的兼容

sonar.scanner.jvmArgs=--add-opens java.base/java.lang=ALL-UNNAMED

整体的文件是这样的:

#Configure here general information about the environment, such as SonarQube server connection details for example

#No information about specific project should appear here

#----- Default SonarQube server

sonar.host.url=http://localhost:9999

#----- Default source code encoding

#sonar.sourceEncoding=UTF-8

# 开启JDK17对反射的兼容

sonar.scanner.jvmArgs=--add-opens java.base/java.lang=ALL-UNNAMED

★如果要使用sonarqube 一定要jdk是1.8★

首先需要去全局那里设置jdk(Manage jenkins → System)

键:

JAVA_HOME

值:

/usr/local/java/jdk-17.0.8+7

键:

JAVA_HOME

值:

/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.262.b10-1.el7.x86_64

在构建项目配置的时候Build Steps → Execute SonarQube Scanner → jdk一定要选择1.8的!!!

流水线构建版本用的jdk17解决办法

要默认的1.8才支持 所以直接从根源上解决这个问题

你当前的系统默认 Java 是 JDK 1.8,路径在:

/usr/bin/java

你执行的:

java -version

输出是:

openjdk version "1.8.0_262"

说明现在 Jenkins 主机上默认使用的是 Java 8,这是符合 SonarQube 6.7.4 的推荐版本,很好!

✅ 接下来你要做的

为了确保 Jenkins 中的 SonarScanner 也用 Java 8 运行,你还需要修改如下:

✅ 方法一:修改 sonar-scanner 启动脚本(推荐)

vi /var/lib/jenkins/tools/hudson.plugins.sonar.SonarRunnerInstallation/sonar-scanner/bin/sonar-scanner

在顶部添加下面两行 👇:

export JAVA_HOME=/usr

export PATH=$JAVA_HOME/bin:$PATH

模拟SonaQube代码审查机制

C:\Users\Pluminary\Desktop\web_demo\src\main\java\com\itheima\HelloServlet.java

package com.itheima;

import javax.servlet.ServletException;

import javax.servlet.http.HttpServlet;

import javax.servlet.http.HttpServletRequest;

import javax.servlet.http.HttpServletResponse;

import java.io.IOException;

/**

*

*/

public class HelloServlet extends HttpServlet {

@Override

protected void doGet(HttpServletRequest req, HttpServletResponse resp) throws ServletException, IOException {

super.doPost(req,resp);

}

@Override

protected void doPost(HttpServletRequest req, HttpServletResponse resp) throws ServletException, IOException {

//模拟代码错误

int i = 100/0;

//模拟冗余代码

int a = 100;

a = 200;

resp.getWriter().write("hello Servlet!");

}

}

在项目添加SonaQube代码审查(流水线项目)不在Jenkins里面写配置,在项目的文件里面写!

sonar-project.properties

# must be unique in a given SonarQube instance

sonar.projectKey=web_demo_pipline

# this is the name and version displayed in the SonarQube UI. Was mandatory prior to SonarQube 6.1.

sonar.projectName=web_demo_pipline

sonar.projectVersion=1.0

# Path is relative to the sonar-project.properties file. Replace "\" by "/" on Windows.

# This property is optional if sonar.modules is set.

sonar.sources=.

sonar.exclusions=**/test/**,**/target/**

sonar.java.source=1.8

sonar.java.target=1.8

# Encoding of the source code. Default is default system encoding

sonar.sourceEncoding=UTF-8

pipeline {

agent any

tools {

// 使用 Jenkins 配置好的 JDK 1.8(别名需和你Jenkins中配置一致)

jdk 'jdk-1.8.0'

}

environment {

// Sonar Scanner JVM 启动参数,开启必要的module访问权限

SONAR_SCANNER_OPTS = '--add-opens=java.base/java.lang=ALL-UNNAMED ' +

'--add-opens=java.base/java.lang.reflect=ALL-UNNAMED ' +

'--add-opens=java.base/java.io=ALL-UNNAMED'

}

stages {

stage('Pull Code') {

steps {

checkout scmGit(

branches: [[name: "*/${branch}"]],

extensions: [],

userRemoteConfigs: [[

credentialsId: 'ca22e56f-0ecc-4fdc-965d-01e329a0b68a',

url: 'http://192.168.200.132:82/lanyun_group/web_demo.git'

]]

)

}

}

stage('Build Project') {

steps {

sh 'mvn clean package'

}

}

stage('SonarQube Scan') {

steps {

// 强制切换到 JDK8 环境,避免默认JDK17导致权限异常

withEnv([

'JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.262.b10-1.el7.x86_64',

'PATH=/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.262.b10-1.el7.x86_64/bin:' + env.PATH

]) {

sh '''

/var/lib/jenkins/tools/hudson.plugins.sonar.SonarRunnerInstallation/sonar-scanner/bin/sonar-scanner \

-Dsonar.projectKey=web_demo_freestyle \

-Dsonar.host.url=http://192.168.200.129:9999 \

-Dsonar.sources=. \

-Dsonar.exclusions=**/test/**,**/target/** \

-Dsonar.java.source=1.8 \

-Dsonar.java.target=1.8

'''

}

}

}

stage('Publish') {

steps {

deploy adapters: [tomcat8(

alternativeDeploymentContext: '',

credentialsId: 'e847a130-29c3-4d0b-bf35-db8d00de7950',

path: '',

url: 'http://192.168.200.131:8090/'

)], contextPath: null, war: 'target/*.war'

}

}

}

post {

always {

emailext(

subject: '构建通知:${PROJECT_NAME} - Build # ${BUILD_NUMBER} - ${BUILD_STATUS}!',

body: '${FILE,path="email.html"}',

to: '2523419709@qq.com'

)

}

}

}

Jenkins+Docker+SpringCloud微服务持续集成(上)

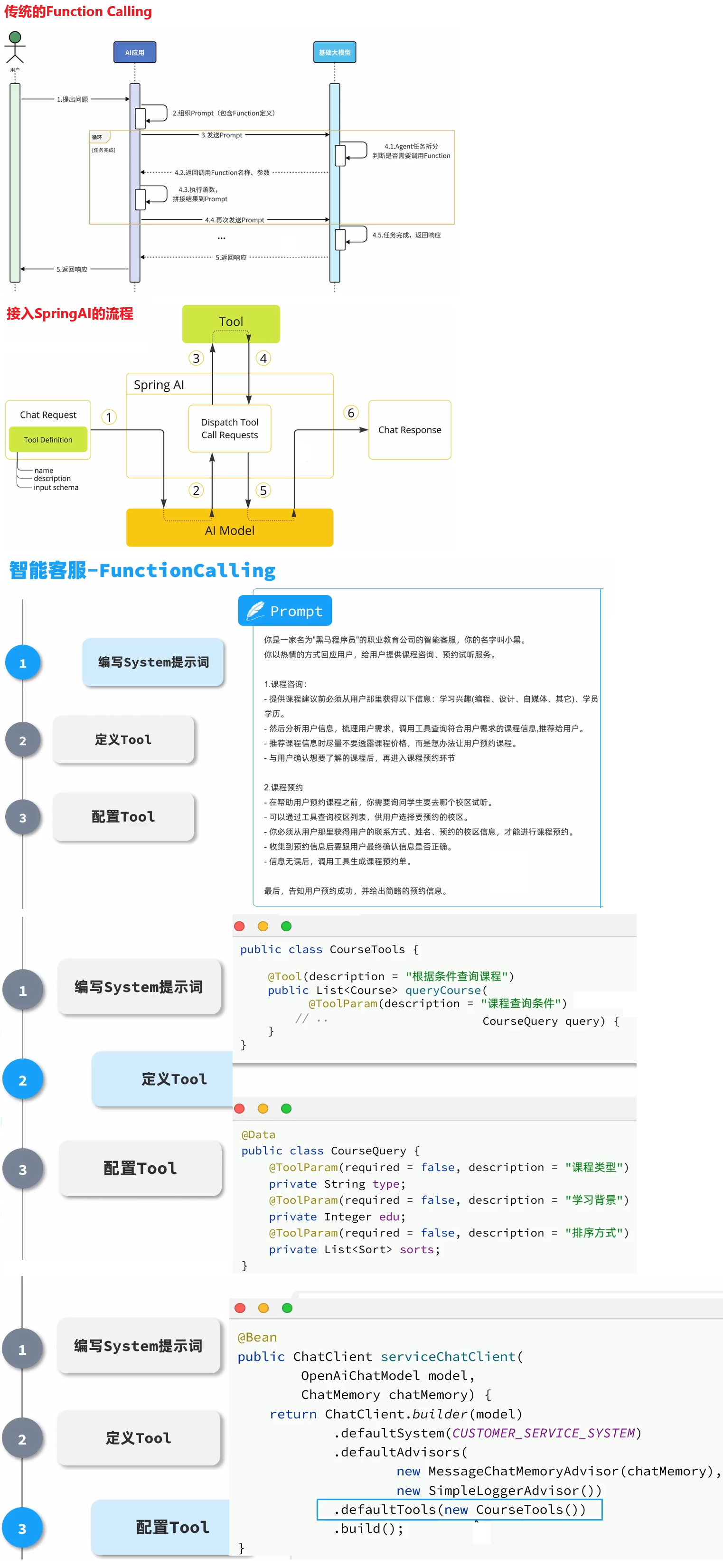

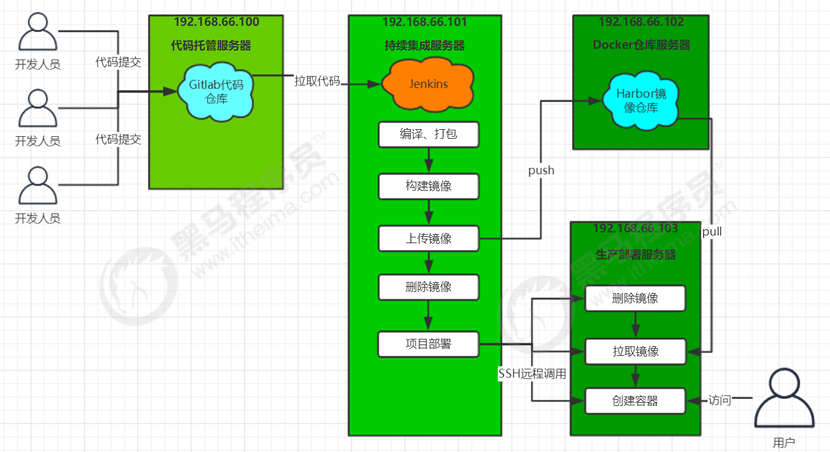

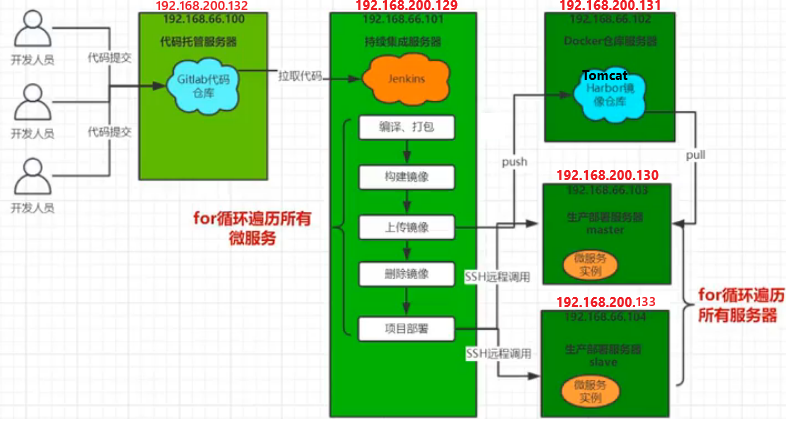

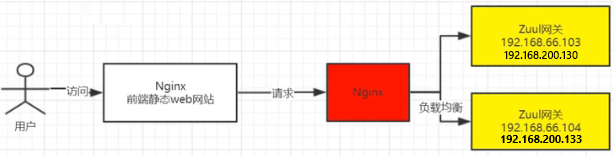

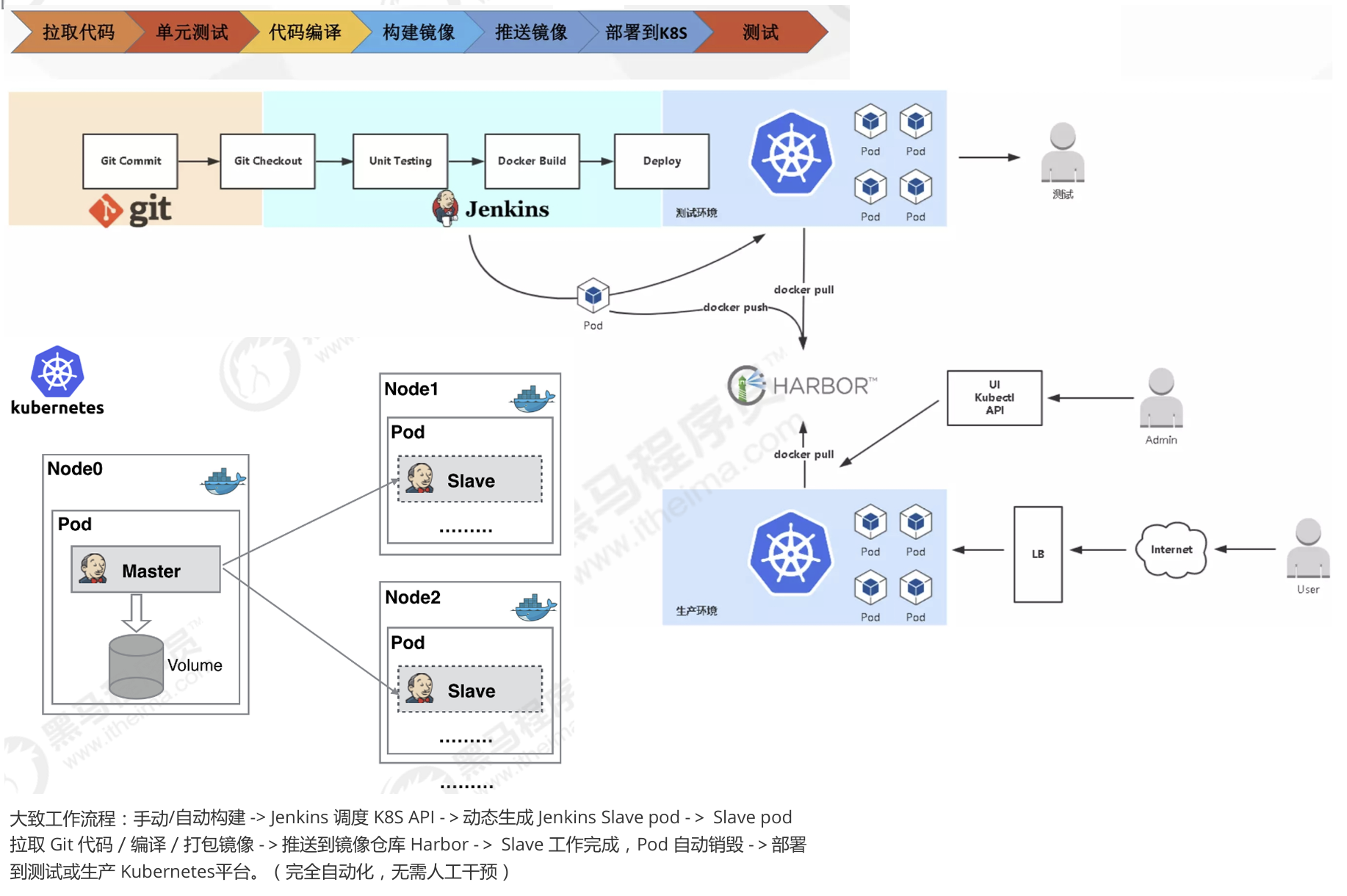

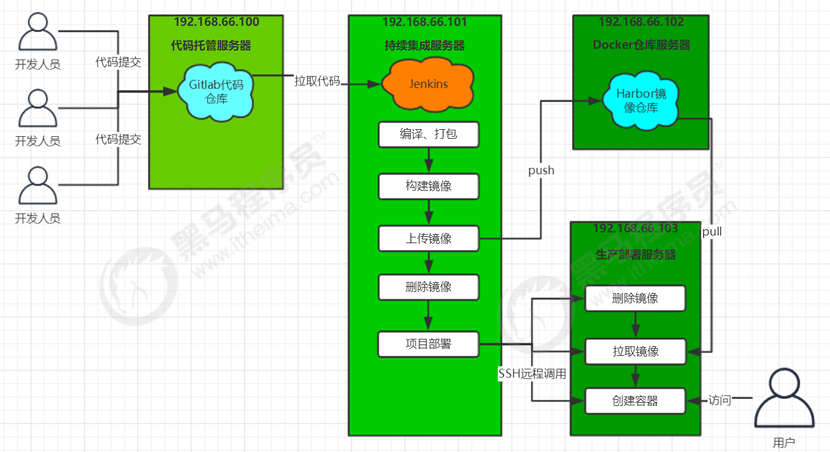

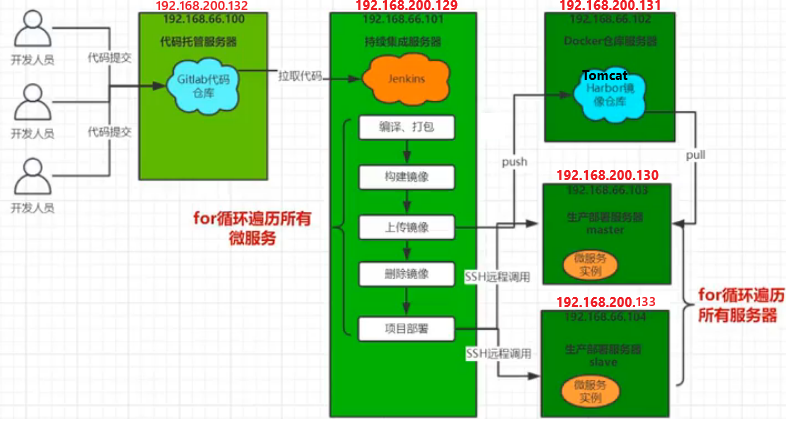

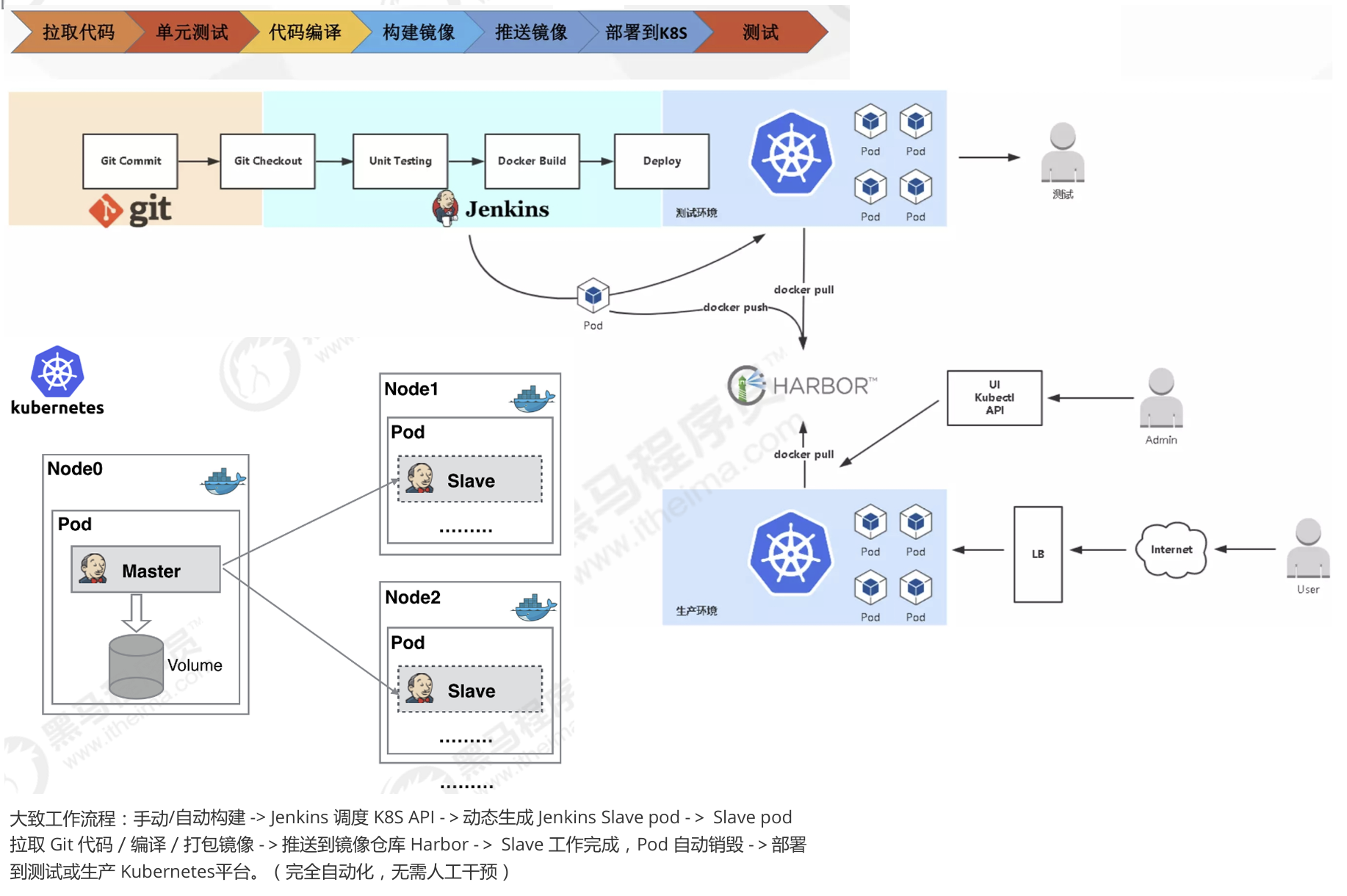

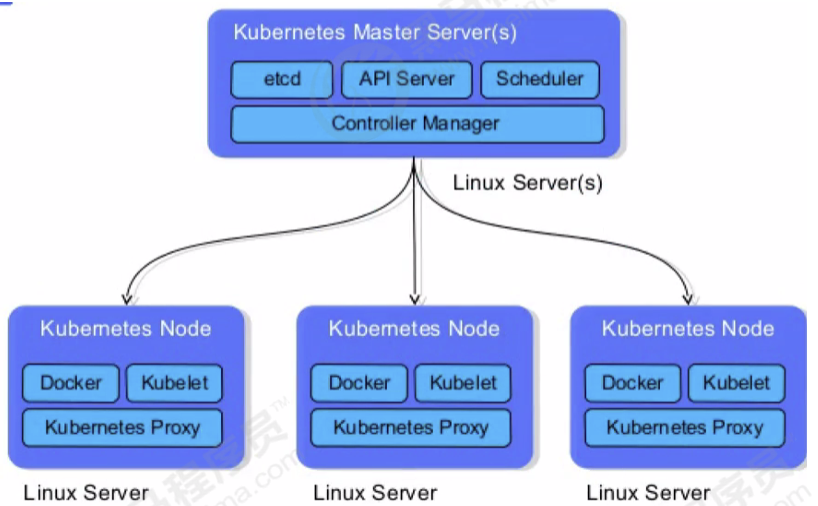

Jenkins+Docker+SpringCloud持续集成流程说明

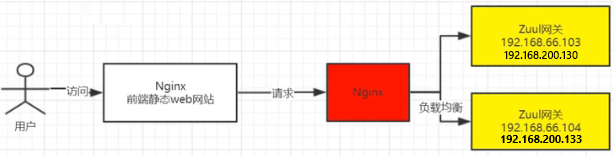

大致流程说明:

1)开发人员每天把代码提交到Gitlab代码仓库

2)Jenkins从Gitlab中拉取项目源码,编译并打成jar包,然后构建成Docker镜像,将镜像上传到 Harbor私有仓库。

3)Jenkins发送SSH远程命令,让生产部署服务器到Harbor私有仓库拉取镜像到本地,然后创建容器。

4)最后,用户可以访问到容器

服务列表(红色的软件为需要安装的软件,黑色代表已经安装)

| 服务器名称 |

IP地址 |

安装的软件 |

| 代码托管服务器 |

192.168.200.132 |

Gitlab |

| 持续集成服务器 |

192.168.200.129 |

Jenkins,Maven,Docker18.06.1-ce |

| Docker仓库服务器 |

|

Docker18.06.1-ce,Harbor1.9.2 |

| 生产部署服务器 |

|

Docker18.06.1-ce |

SpringCloud微服务源码概述

项目架构:前后端分离

后端技术栈:SpringBoot+SpringCloud+SpringDataJpa(Spring全家桶)

位置:C:\Users\Pluminary\Desktop\HouDuan\tensquare_parent

微服务项目结构:

- tensquare_parent :父工程,存放基础配置

- tensquare_common :通用工程,存放工具类

- tensquare_eureka_server:SpringCloud的Eureka注册中心

- tensquare_zuul :SpringCloud的网关服务

- tensquare_admin_service :基础权限认证中心,负责用户认证(使用JWT认证)

- tensquare_gathering : 一个简单的业务模块,活动微服务相关逻辑

数据库结构:

- tensquare_user :用户认证数据库,存放用户账户数据。对应tensquare_admin_service微服务

- tensquare_gathering :活动微服务数据库。对应tensquare_gathering微服务

微服务配置分析:

tensquare_eureka

tensquare_zuul

tensquare_admin_service

tensquare_gathering

查看效果

application.yaml

spring:

application:

name: EUREKA-HA

---

spring:

profiles: eureka-server1

server:

port: 10086

eureka:

instance:

hostname: localhost

client:

service-url:

defaultZone: http://localhost:10086/eureka/,http://localhost:10087/eureka/

---

spring:

profiles: eureka-server2

server:

port: 10087

eureka:

instance:

hostname: localhost

client:

service-url:

defaultZone: http://localhost:10086/eureka/,http://localhost:10087/eureka/

依次开启这些服务:tensquare_eureka_server → tensquare_zuul → tensquare_admin_service → tensquare_gathering

tensquare_eureka_server 要在配置的地方配置两个【复制出多一个】配置信息添加Program arguments

EurekaServerApplication-Server1:-spring.profiles.active=eureka-server1

EurekaServerApplication-Server2:–spring.profiles.active=eureka-server2

调用postman

测试gathering接口的时候一定要在请求头带token

测试获得token接口的时候一定是post请求 请求体是json形式

GET:http://localhost:10020/gathering/gathering

Headers:这里的token是去post请求获得

POST:http://localhost:10020/admin/admin/login

json:{

"loginname": "admin",

"password": "123456"

}

本地部署(1)-SpringCloud微服务部署

本地运行微服务

- 逐一启动微服务

- 使用postman测试功能是否可用

本地部署微服务

打开idea终端

PS C:\Users\Pluminary\Desktop\HouDuan\tensquare_parent>

托选想要打包的项目到终端

PS C:\Users\Pluminary\Desktop\HouDuan\tensquare_parent\tensquare_eureka_server> mvn clean package

此时就打好了jar包

C:\Users\Pluminary\Desktop\HouDuan\tensquare_parent\tensquare_eureka_server\target的tensquare_eureka_server-1.0-SNAPSHOT.jar

必须导入该插件

在根pom.xml中

<build>

<plugins>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

</plugin>

</plugins>

</build>

★ 这个就可以对springcloud进行打包 微服务的jar可以独立部署 扔到任何一个服务就可以单独运行 而不需要借助单独的tomcat ★

打包后在 target下产生jar包

java -jar xxx.jar

C:\Users\Pluminary\Desktop>java -jar tensquare_eureka_server-1.0-SNAPSHOT.jar

2025-07-01 15:33:09.363 INFO 27172 --- [ main] o.s.core.annotation.AnnotationUtils : Failed to introspect annotations on class org.springframework.cloud.netflix.eureka.config.EurekaDiscoveryClientConfigServiceBootstrapConfiguration: java.lang.IllegalStateException: Could not obtain annotation attribute value for public abstract java.lang.Class[] org.springframework.boot.autoconfigure.condition.ConditionalOnClass.value()

2025-07-01 15:33:09.373 INFO 27172 --- [ main] s.c.a.AnnotationConfigApplicationContext : Refreshing org.springframework.context.annotation.AnnotationConfigApplicationContext@8f4ea7c: startup date [Tue Jul 01 15:33:09 CST 2025]; root of context hierarchy

WARNING: An illegal reflective access operation has occurred

WARNING: Illegal reflective access by org.springframework.cglib.core.ReflectUtils$1 (jar:file:/C:/Users/Pluminary/Desktop/tensquare_eureka_server-1.0-SNAPSHOT.jar!/BOOT-INF/lib/spring-core-5.0.5.RELEASE.jar!/) to method java.lang.ClassLoader.defineClass(java.lang.String,byte[],int,int,java.security.ProtectionDomain)

WARNING: Please consider reporting this to the maintainers of org.springframework.cglib.core.ReflectUtils$1

WARNING: Use --illegal-access=warn to enable warnings of further illegal reflective access operations

WARNING: All illegal access operations will be denied in a future release

2025-07-01 15:33:09.531 INFO 27172 --- [ main] f.a.AutowiredAnnotationBeanPostProcessor : JSR-330 'javax.inject.Inject' annotation found and supported for autowiring

2025-07-01 15:33:09.554 INFO 27172 --- [ main] trationDelegate$BeanPostProcessorChecker : Bean 'configurationPropertiesRebinderAutoConfiguration' of type [org.springframework.cloud.autoconfigure.ConfigurationPropertiesRebinderAutoConfiguration$$EnhancerBySpringCGLIB$$83532275] is not eligible for getting processed by all BeanPostProcessors (for example: not eligible for auto-proxying)

. ____ _ __ _ _

/\\ / ___'_ __ _ _(_)_ __ __ _ \ \ \ \

( ( )\___ | '_ | '_| | '_ \/ _` | \ \ \ \

\\/ ___)| |_)| | | | | || (_| | ) ) ) )

' |____| .__|_| |_|_| |_\__, | / / / /

=========|_|==============|___/=/_/_/_/

:: Spring Boot :: (v2.0.1.RELEASE)

本地部署(2)-前端静态web网站

前端技术栈:NodeJS+VueJS+ElementUI

使用Visual Studio Code打开源码

位置:C:\Users\Pluminary\Desktop\QianDuan\tensquareAdmin

因为老版本无法继续用最新的nodejs

需要用nvm进行统一的nodejs管理 如果无法直接nvm下载的话

我们可以去官网下载安装包zip后解压进去 改名就行

✅ 1. 下载 Node.js v10.24.1 64位 zip 版本

你可以从官方链接下载:

📦 下载地址(Windows 64位):

bash

复制编辑

https://nodejs.org/dist/v10.24.1/node-v10.24.1-win-x64.zip

下载后,解压得到一个文件夹(比如叫 node-v10.24.1-win-x64)

✅ 2. 放入 NVM 的版本目录

将你解压得到的 node-v10.24.1-win-x64 文件夹重命名为:

10.24.1

然后放入这个目录下:

C:\Program Files\nvm\versions\10.24.1\

C:\Users\Pluminary\Desktop\QianDuan\tensquareAdmin>nvm list

- 20.12.0 (Currently using 64-bit executable)

10.24.1

C:\Users\Pluminary\Desktop\QianDuan\tensquareAdmin>nvm use 10.24.1

Now using node v10.24.1 (64-bit)

🚀 步骤 1:重新下载对应 binding.node

在项目目录下运行:

bash

复制编辑

npm rebuild node-sass

I Your application is running here: http://localhost:9528 前端即可启动!

name: admin password: 123456

[十次方社交平台-管理员后台] (http://localhost:9528/#/gathering/index)

环境准备(1)-Docker快速入门

Docker 是一个开源的应用容器引擎,基于 Go 语言 并遵从 Apache2.0 协议开源。 Docker 可以让开发者打包他们的应用以及依赖包到一个轻量级、可移植的容器中,然后发布到任何流 行的 Linux 机器上,也可以实现虚拟化。 容器是完全使用沙箱机制,相互之间不会有任何接口(类似 iPhone 的 app),更重要的是容器性能开销 极低。 Docker容器技术 vs 传统虚拟机技术

|

虚拟机 |

容器 |

| 占用磁盘空间 |

非常大,GB级 |

小,MB甚至KB级 |

| 启动速度 |

慢。分钟级 |

快,秒级 |

| 运行状态 |

运行于Hypervisor上 |

直接运行在宿主机内核上 |

| 并发性 |

一台宿主机上十几个,最多几十个 |

上百个,甚至数百上千个 |

| 性能 |

逊于宿主机 |

接近宿主机本地进程 |

| 资源利用率 |

低 |

高 |

简单一句话总结:Docker技术就是让我们更加高效轻松地将任何应用在Linux服务器部署和使用。

Docker安装

1)卸载旧版本

yum list installed | grep docker 列出当前所有docker的包

yum -y remove docker的包名称 卸载docker包

rm -rf /var/lib/docker 删除docker的所有镜像和容器

2)安装必要的软件包

sudo yum install -y yum-utils \ device-mapper-persistent-data \ lvm2

3)设置下载的镜像仓库

sudo yum-config-manager --add-repo https://download.docker.com/linux/centos/docker-ce.repo

4)列出需要安装的版本列表

yum list docker-ce --showduplicates | sort -r

docker-ce.x86_64 3:18.09.1-3.el7

docker-ce.x86_64 3:18.09.0-3.el7

docker-ce.x86_64 18.06.1.ce-3.el7

docker-ce.x86_64 18.06.0.ce-3.el7

……

5 )安装指定版本(这里使用18.0.1版本)

sudo yum install docker-ce-18.06.1.ce

6)查看版本

docker -v

7)启动Docker

sudo systemctl start docker 启动

sudo systemctl enable docker 设置开机启动

8)添加阿里云镜像下载地址

sudvi /etc/docker/daemon.json

{

“registry-mirrors”: [“https://zydiol88.mirror.aliyuncs.com"]

}

9 )重启Docker

sudo systemctl restart docker

第四步看这里:你现在的问题还是和之前一样:

❌ 无法访问 Docker 官方源(https://download.docker.com/...),报错 curl#35 - TCP connection reset by peer。

✅ 解决方法:使用国内镜像(如清华、阿里)

你需要 手动切换 Docker yum 源为国内镜像,否则无法继续安装。下面是最直接可行的解决方法。

🚀 一键换成清华源(CentOS 7 示例)

请复制以下命令到你的服务器执行:

bash复制编辑sudo tee /etc/yum.repos.d/docker-ce.repo <<-'EOF'

[docker-ce-stable]

name=Docker CE Stable - Tsinghua Mirror

baseurl=https://mirrors.tuna.tsinghua.edu.cn/docker-ce/linux/centos/7/x86_64/stable

enabled=1

gpgcheck=1

gpgkey=https://mirrors.tuna.tsinghua.edu.cn/docker-ce/linux/centos/gpg

EOF

🔁 然后执行:

sudo yum clean all

sudo yum makecache fast

✅ 安装 Docker 指定版本(比如 18.06)

sudo yum install docker-ce-18.06.1.ce docker-ce-cli-18.06.1.ce containerd.io

或者查看所有可用版本:

yum list docker-ce --showduplicates

🟢 启动并设置开机启动:

sudo systemctl start docker

sudo systemctl enable docker

Docker基本命令快速入门

1)镜像命令

[docker配置镜像Docker pull时报错:https://registry-1.docker.io/v2/ - 知乎] (https://zhuanlan.zhihu.com/p/24228872523)

这个错误表明Docker客户端尝试访问Docker Hub或其他Docker注册中心时出现了问题。具体来说,是在尝试获取注册中心API的响应时遇到了错误。可能的原因包括网络问题、认证问题、注册中心URL不正确或者注册中心服务本身不可用。

2、解决方法

systemctl status docker

sudo mkdir -p /etc/docker

vim /etc/docker/daemon.json

添加:

{

"registry-mirrors" : ["https://docker.registry.cyou",

"https://docker-cf.registry.cyou",

"https://dockercf.jsdelivr.fyi",

"https://docker.jsdelivr.fyi",

"https://dockertest.jsdelivr.fyi",

"https://mirror.aliyuncs.com",

"https://dockerproxy.com",

"https://mirror.baidubce.com",

"https://docker.m.daocloud.io",

"https://docker.nju.edu.cn",

"https://docker.mirrors.sjtug.sjtu.edu.cn",

"https://docker.mirrors.ustc.edu.cn",

"https://mirror.iscas.ac.cn",

"https://docker.rainbond.cc",

"https://do.nark.eu.org",

"https://dc.j8.work",

"https://dockerproxy.com",

"https://gst6rzl9.mirror.aliyuncs.com",

"https://registry.docker-cn.com",

"http://hub-mirror.c.163.com",

"http://mirrors.ustc.edu.cn/",

"https://mirrors.tuna.tsinghua.edu.cn/",

"http://mirrors.sohu.com/"

],

"insecure-registries" : [

"registry.docker-cn.com",

"docker.mirrors.ustc.edu.cn"

],

"debug": true,

"experimental": false

}

重载和重启dockers服务

sudo systemctl daemon-reload

sudo systemctl restart docker

docker info

重新执行

docker run hello-world

镜像:相当于应用的安装包,在Docker部署的任何应用都需要先构建成为镜像

docker search 镜像名称 搜索镜像

docker pull 镜像名称 拉取镜像

docker images 查看本地所有镜像

docker rmi -f 镜像名称 删除镜像

docker pull openjdk:8-jdk-alpine

[root@localhost ~]# docker pull openjdk:8-jdk-alpine

8-jdk-alpine: Pulling from library/openjdk

e7c96db7181b: Pull complete

f910a506b6cb: Pull complete

c2274a1a0e27: Pull complete

Digest: sha256:94792824df2df33402f201713f932b58cb9de94a0cd524164a0f2283343547b3

Status: Downloaded newer image for openjdk:8-jdk-alpine

[root@localhost ~]#

2)容器命令

容器:容器是由镜像创建而来。容器是Docker运行应用的载体,每个应用都分别运行在Docker的每个 容器中。

docker run -i 镜像名称:标签 运行容器(默认是前台运行)

docker ps 查看运行的容器

docker ps -a 查询所有容器

常用的参数:

-i:运行容器

-d:后台守方式运行(守护式)

--name:给容器添加名称

-p:公开容器端口给当前宿主机

-v:挂载目录

docker exec -it 容器ID/容器名称 /bin/bash 进入容器内部

docker start/stop/restart 容器名称/ID 启动/停止/重启容器

docker rm -f 容器名称/ID 删除容器

docker run -i nginx 运行容器

docker run -di nginx 后台运行容器

运行的时候创建端口 把端口暴露给宿主机 这样宿主机就可以进行ip地址+端口的访问虚拟机的容器了

-p是公开端口 外部用90端口访问80端口

docker run -di -p 90:80 nginx

[root@localhost ~]# docker run -di -p 90:80 nginx

04726503f6ee2d053b54b6361d128827d5fb26b867c8fbd5439a370a4ac137d9

[root@localhost ~]# docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

04726503f6ee nginx “/docker-entrypoint.…” 29 seconds ago Up 27 seconds 0.0.0.0:90->80/tcp relaxed_goldberg

此时用宿主机去访问:[Welcome to nginx!] (http://192.168.200.129:90/)

Welcome to nginx!

If you see this page, the nginx web server is successfully installed and working. Further configuration is required.

For online documentation and support please refer to nginx.org.

Commercial support is available at nginx.com.

Thank you for using nginx.

进入某个容器内部查看其内容:

[root@localhost ~]# docker exec -it 04726503f6ee /bin/bash

root@04726503f6ee:/# ls

bin boot dev docker-entrypoint.d docker-entrypoint.sh etc home lib lib64 media mnt opt proc root run sbin srv sys tmp usr var

root@04726503f6ee:/#

删除容器

[root@localhost ~]# docker ps -a

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

04726503f6ee nginx “/docker-entrypoint.…” 4 minutes ago Up 4 minutes 0.0.0.0:90->80/tcp relaxed_goldberg

9b9b1ec3e7a1 nginx “/docker-entrypoint.…” 10 minutes ago Up 8 minutes 80/tcp gracious_knuth

4fb9d9e6858a hello-world “/hello” 29 minutes ago Exited (0) 29 minutes ago elated_bhaskara

[root@localhost ~]# docker rm -f 4fb9d9e6858a

4fb9d9e6858a

虚拟机变化ip 导致无法ping通 解决办法

cd /etc/sysconfig/network-scripts/

vi ifcfg-ens33

❗核心问题总结:

你的宿主机(Windows)的真实联网网卡是:

- 无线网卡 WLAN

- IP:

192.168.31.103

- 网关:

192.168.31.1

而你的 VMware 虚拟机设置的是:

- 静态 IP:192.168.200.132

- 网关:

192.168.200.1

- 网络模式:你设为桥接模式

❗问题本质:

你的虚拟机静态 IP 设置在 192.168.200.x 网段,但 宿主机是在 192.168.31.x 网段,说明你的桥接实际上根本没有生效,或者桥接到了错误的物理网卡。

✅ 最快修复方案(推荐,100% 可行):

🛠️ 步骤一:修改 VMware 桥接设置

- 关闭虚拟机

- 打开 VMware 主界面 → 选择你的虚拟机 → 设置(Settings)→ 网络适配器

- 选择:

- ✔️ 网络连接 → 桥接模式(Bridged)

- 点开旁边的 “桥接设置(Bridge Settings)”

- 手动选择你的 Wi-Fi 无线网卡(例如 Intel Wireless-AC 或 Realtek Wireless)

- 取消勾选“复制物理网络连接状态”这一项

- 保存设置

🛠️ 步骤二:修改虚拟机内 IP 设置

由于你真实网络是 192.168.31.x,所以虚拟机也应该设置为这个网段,例如:

编辑 vi /etc/sysconfig/network-scripts/ifcfg-ens33:

BOOTPROTO=static

NAME=ens33

DEVICE=ens33

ONBOOT=yes

IPADDR=192.168.31.150 # ← 随便取一个没被占用的

NETMASK=255.255.255.0

GATEWAY=192.168.31.1 # 这个是在宿主机网络下的环境网关 ipconfig

DNS1=8.8.8.8

然后执行:

sudo systemctl restart network

或者:

sudo ifdown ens33 && sudo ifup ens33

✅ 步骤三:在 Windows 上 ping 新的虚拟机 IP

ping 192.168.31.150

🧠 如果你担心 IP 冲突怎么办?

在 Windows 上运行:

ping 192.168.31.150

如果 ping 不通,就说明这个 IP 是空闲的,可以用。

✅ 替代方案(保留 NAT 模式)

如果你不想改桥接模式,可以继续用 VMware NAT 模式,那就让虚拟机保留原来的:

- IP:192.168.200.132

- 网关:192.168.200.1

- 然后通过端口转发(NAT 端口映射)来从主机访问虚拟机(需要手动配置)

但 桥接 + 静态 IP 更简单、稳定、兼容性好。

✅ 最终目标

你的宿主机和虚拟机 在同一个网段(如都在 192.168.31.x),并且虚拟机网卡状态为 UP,那 ping 肯定通!

🔚 结论

| 问题 |

解决方法 |

| 虚拟机 IP 设置错网段了 |

改为 192.168.31.x(和主机一样的网段) |

| 桥接失败 |

手动指定桥接物理网卡为你的 无线网卡,不能选自动 |

| 不能 ping 通 |

网卡 DOWN → 启动;IP 不通 → 改网段;防火墙 → 暂停 |

如果ip a show ens33没有ip地址怎么办 这样会导致moba连不上